除了Zen CPU架构和RDNA客户端GPU架构的更新,AMD最近还更新了他们的CDNA服务器GPU架构和相关的Instinct产品路线图。在接下来的两年里,CPU和客户端GPU的发展可以说是一帆风顺,而AMD则打算大幅调整其服务器端GPU产品。

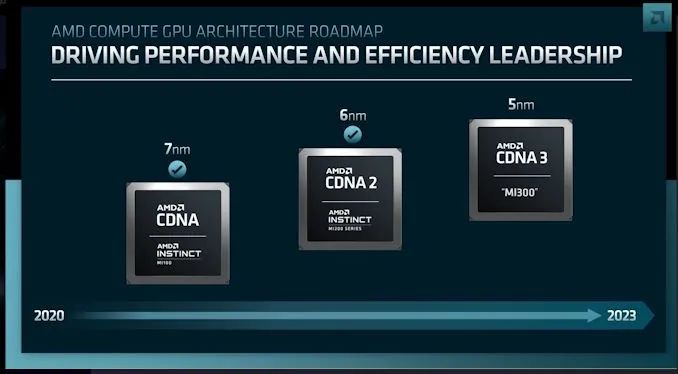

让我们先从AMD的服务器GPU架构路线图开始。继AMD公司目前的CDNA 2架构之后,MI200系列Instinct加速器将采用CDNA 3架构。与AMD的其他路线图不同的是,该公司此次并没有提供两年的路线图。同时,服务器GPU路线图只推出到2023年,AMD的下一个服务器GPU架构将于明年推出。

我们对CDNA 3的第一次了解发现了很多细节。AMD透漏了从架构到有关产品的一些基本信息——由CPU和GPU小芯片组成的数据中心APU。

综上所述,基于CDNA 3架构的GPU将建立在5纳米工艺上。就像之前的基于CDNA 2的MI200加速器一样,它将依赖小芯片将内存、缓存和处理器内核全部组合在一个封装中。值得注意的是,AMD称之为“3D芯片”设计,这意味着不仅小芯片堆叠在基板上,而且其他芯片也将堆叠在小芯片之上,就像AMD为Zen 3 CPU设计的V-Cache一样。

这种比较在这里特别适用,因为AMD将把它的无限缓存技术引入到CDNA 3架构中。而且,就像上面的V-Cache的例子一样,从AMD的设计来看,他们会将缓存和逻辑堆叠成独立的芯片,而不是像他们的客户端GPU那样将其集成到一个整体芯片中。由于这种堆叠的特性,CDNA 3的无限缓存芯片将位于处理器芯片之下,AMD似乎将非常耗电的逻辑芯片放在堆栈的顶部,以便有效冷却。

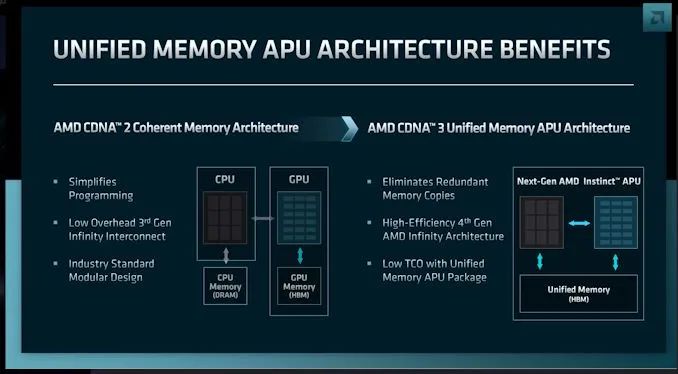

CDNA 3也将采用AMD的第四代无限架构。对于GPU来说,IA4与AMD的芯片创新是携手并进的。具体来说,它将使2.5D/3D堆叠芯片与IA一起使用,使一个包内的所有芯片共享一个统一的、完全一致的存储子系统。这相对IA3和目前的MI200加速器是一个巨大的飞跃,虽然提供了内存一致性,但没有统一的内存地址空间。因此,尽管MI200加速器本质上在一个封装中充当两个GPU,但IA4将让CDNA 3/MI300加速器作为单个芯片运行。

AMD的图表还显示,HBM内存再次在这里使用。AMD没有具体说明HBM的版本,但考虑到2023年的时间框架,很有可能会是HBM3。

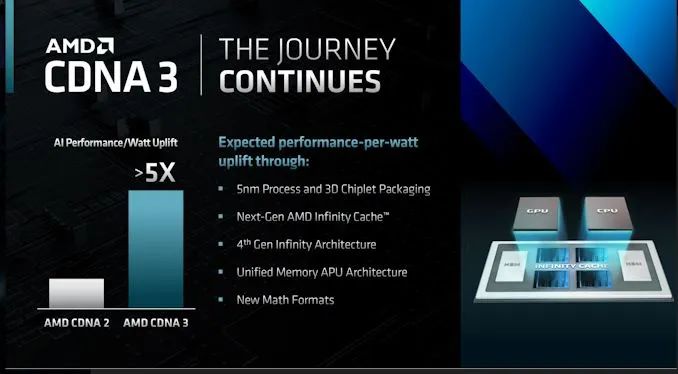

在架构上,AMD也将采取一些措施来改善其高性能加速器的AI性能。据该公司称,他们正在增加对新的混合精确数学格式的支持。虽然还没有明确说明,但AMD在AI工作负载中的每瓦性能提升超过5倍,这强烈暗示AMD正在为CNDA 3显着改造和扩展其矩阵内核,因为5倍的性能远远超过了单是芯片改进所能提供的性能。

MI300: AMD的第一款分块数据中心APU

但是AMD不会止步于仅仅建造一个更大的GPU,他们也不会仅仅为了让GPU在共享内存池中工作而统一多芯片架构的内存池。相反,AMD的野心远不止于此。有了高性能的CPU和GPU核心,AMD在集成方面迈出了下一步,正在构建一个分体式的数据中心APU——一种将CPU和GPU核心结合到单个封装中的芯片。

数据中心APU目前的代号是MI300,AMD已经为之努力了一段时间。MI200和Infinity Architecture 3允许AMD CPU和GPU在一个连贯的内存架构下一起工作,下一步是在封装和内存架构方面将CPU和GPU进一步结合在一起。

对于内存问题来说,统一的架构给MI300带来了几个主要的好处。从性能的角度来看,这通过消除冗余的内存拷贝来改善问题;处理器不再需要将数据复制到自己专用的内存池来访问/修改数据。统一的内存池还意味着不需要第二个内存芯片池——在这种情况下,通常是连接到CPU的DRAM。

MI300将把CDNA 3GPU小芯片和Zen 4 CPU小芯片组合到一个处理器封装中。反过来,这两个处理器池将共享封装HBM内存。而且,大概还有无限缓存。

如前所述,AMD将大量利用小芯片来实现这一目标。CPU内核、GPU内核、Infinity Cache和HBM都是不同的小芯片,其中一些将相互堆叠。因此,这将是不同于AMD之前制造的任何其他芯片的芯片,这将是AMD将芯片集成到他们的产品设计中所付出的最大努力。

与此同时,AMD非常明确地表示,他们正在内存带宽和应用延迟方面争夺市场领导地位。如果AMD能做到这一点,对公司来说将是一个重大的成就。话虽如此,他们并不是第一家将HBM与CPU内核配对的公司,英特尔的Sapphire Rapids Xeon同样使用了这种方法,所以我们将拭目以待MI300如何在这方面获得优势。

至于更具体的AI性能问题,AMD声称APU将提供优于MI250X加速器8倍的训练性能。这进一步证明,与MI200系列相比,AMD将对其GPU矩阵内核进行一些重大改进。

总体而言,AMD的服务器GPU发展轨迹与英特尔和英伟达在过去几个月里公布的非常相似。这三家公司都在致力于CPU+GPU产品的结合;NVIDIA推出了Grace Hopper (Grace + H100),Intel推出了Falcon Shores xpu (CPU + GPU混合搭配),现在MI300在单个封装上同时使用了CPU和GPU芯片。在这三种情况下,这些技术的目标都是将最好的CPU和最好的GPU结合起来,以应对不受两者约束的工作负载。就AMD而言,该公司相信他们拥有最好的CPU和最好的GPU。

在接下来的几个月里,我们有望看到更多关于CDNA 3和MI300的信息。

审核编辑 :李倩

-

amd

+关注

关注

25文章

5647浏览量

139022 -

gpu

+关注

关注

28文章

5099浏览量

134459 -

服务器

+关注

关注

13文章

10094浏览量

90883

原文标题:GPU+CPU=AMD MI300数据中心APU!

文章出处:【微信号:SSDFans,微信公众号:SSDFans】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

物联网数据中心是什么?有什么功能?

华为数字能源亮相2025开放数据中心大会

睿海光电以高效交付与广泛兼容助力AI数据中心800G光模块升级

FLOW Digital Infrastructure宣布在东京市中心新建数据中心

PCIe协议分析仪在数据中心中有何作用?

中型数据中心中的差分晶体振荡器应用与匹配方案

小型数据中心晶振选型关键参数全解

适用于数据中心和AI时代的800G网络

优化800G数据中心:高速线缆、有源光缆和光纤跳线解决方案

【「芯片通识课:一本书读懂芯片技术」阅读体验】初识芯片样貌

伟创力中间总线转换器优化数据中心能源效率

由CPU和GPU小芯片组成的数据中心APU

由CPU和GPU小芯片组成的数据中心APU

评论