人工智能和机器学习在安全中的应用是一个屡见不鲜的话题,同样在RSAC2022大会中出现了围绕AI/ML为重点的焦点议题。此次会议中重点探讨了AI对抗和隐私合规问题,还有时下热门的零信任、API安全和威胁狩猎等。

RSAC2022人工智能安全议题

以智能对抗智能

是数字化时代下的安全趋势

在数字化转型时代,对抗愈发严峻,攻击工具更加智能化。相信有过安全分析工作经验的人都对ATT&CK矩阵并不陌生,而对抗性机器学习威胁矩阵ATLAS(Adversarial Threat Landscape for Artificial-Intelligence Systems)参照了ATT&CK矩阵技术的框架设计,在机器学习攻防技术博弈的发展上,框架植入了一系列精心策划的漏洞和攻击行为,使安全分析师能够定位对机器学习系统的攻击。

对抗性机器学习威胁矩阵ATLAS

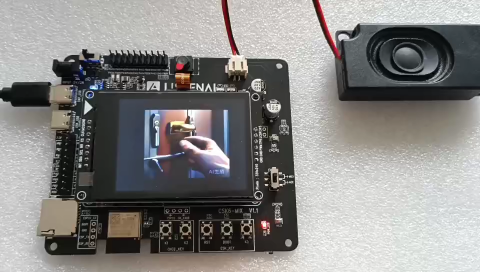

在RSA大会的实际攻击案例中,来自SAP公司的漏洞管理人员分享了利用收集的图像、语音样本,构建深度虚假社会形象进行网络攻击,使得网络攻击更加智能化。为了防范此类攻击,建议大家不要在社交媒体上留存过多的视频和图片,避免被攻击者收集滥用。

NIST的安全人员在《Measuringthe Difference: Metric Development at NCCoE‘s Securing AI Testbed》话题中分享了如何利用NCCoE的安全AI测试平台Dioptra评估人工智能防御模型脆弱性,演讲者首先介绍了AI模型的三种常见攻击手段:(1)样本投毒:在训练样本中进行投毒;(2)模型逃逸:改变模型预测值;(3)反向工程:进行反向工程窃取模型或数据集。

AI图像预测中的逃逸案例

最后,分享者介绍了如何使用Dioptra工具进行AI模型的加固,包括使用数据增强、进行模型推理前的预处理等。

除了Dioptra工具外,此次大会上还有另外一款工具值得注意——ART(Adversarial Robustness Toolbox),ART是IBM 研究团队开源的、用于检测模型及对抗攻击的工具箱,为开发人员加强AI模型的防御性,让AI系统变得更加安全,目前支持Tensor Flow和Keras深度学习,同时也支持传统机器学习。

“以智能对抗智能”,用于红队和蓝队的ART工具

该工具支持的AI模型对抗攻击类型:

Deep Fool

FastGradient Method

JacobianSaliency Map

UniversalPerturbation

VirtualAdversarial Method

C&WAttack

NewtonFool

对应的防御类型有:

Featuresqueezing

Spatialsmoothing

Labelsmoothing

Adversarialtraining

Virtualadversarial training

由于安全的本质是攻防技术的不断对抗。对应防御方,以智能对抗智能是“正着”,ART工具可以说是以智能对抗智能的一个典型案例。微软、谷歌和MITRE在《Red Teaming AI Systems: The Path, the Prospect and the Perils》话题中共同表明了红队AI是未来,但随着AI对抗,需要更多的工具和框架来保护组织中的AI系统。微软提出的AI风险管理评估框架建议机器学习工程师从多个维度来评估AI模型的影响和风险。

微软的AI风险管理评估框架

以智能对抗智能是当前对抗AI类攻击的主要手段,包括智能威胁分析、狩猎和自动化的响应处置,大会上来自Onee Security 和Acronis的研究人员分别分享了如何通过DS4N6AI工具集(集成了大量的异常检测算法)增强威胁狩猎,基于机器学习和堆栈分析应对无文件勒索高级威胁,在云安全环境下如何使能安全团队进行自动化调查和响应违规行为。

AI的双刃剑:

AI隐私合规问题亟需解决

当然,伴随着人工智能技术的应用,它在为人们带来便利的同时,也暴露出一些问题,例如算法歧视、不公平、缺乏隐私和安全性等。因此,如何以负责的、符合伦理要求的方式使用AI,成为业界关注的焦点之一。

可信AI 8原则:可复现、健壮、公平、隐私、可解释、可问责、透明、安全

解决AI隐私合规问题的“四方法”,首先最重要的是强化规则制定与立法,让组织机构必须清楚了解目前适用于AI领域的隐私要求,才能为AI和机器学习应用建立一个合规的数据保护计划。在本次RSA大会上,重点探讨了欧盟和美国的法律和政策应对人工智能合规问题。

其次,一些安全联盟的参与也至关重要,例如联合国教科文组织(UNESCO)发布的《AI伦理问题建议书》,欧洲理事会的报告《AI系统的监管》,经济合作与发展组织(OECD)的《AI原则》,以及欧盟委员会AI高级别专家组制定的《可信AI伦理指南》。在此次RSA大会上,由算法正义联盟(Algorithmic Justice League,简称AJL)分享了他们的最新研究结果。AJL是一家位于马萨诸塞州剑桥市的数字倡导性非营利组织,由计算机科学家Joy Buolamwini于2016年创立,通过研究、政策宣传来提高社会对人工智能在社会中的使用以及人工智能对社会造成的危害和偏见的认识。

解决AI隐私合规问题的“四方法”

最后是AI风险管理框架和工具支撑,NIST研究人员在大会上介绍通过AIRMF框架解决AI系统可信和风险问题,必须处理好AI治理原则与隐私保护之间的关系。在可执行层面,IBM的AI隐私工具集(ai-privacy-toolkit)通过数据匿名化和最小化帮助开发者解决低维表格类数据的隐私问题,当然模型精度会有所下降,大约2%左右。

IBM的ai-privacy-toolkit实现数据匿名化效果

针对AI模型是否存在偏见,大会上来自SailPoint的在《It’s Not Fair! Detecting Algorithmic Bias with Open Source Tools》话题中提到的aequitas工具能够帮助你评估AI模型的偏见问题,感兴趣的读者可以亲自尝试一下。

aequitas工具评估AI模型偏见问题

更多的优秀工具,笔者都一一汇总在下表中。优秀的开源AI隐私合规类工具

RSA大会上的其他AI议题,还包括了AI在零信任的应用。由于受到新冠疫情影响,远程办公对传统安全体系结构带来的挑战。大会上分享了PKI、加密、机器身份在IAM中的快速增长,以及如何通过Workload Segmentation降低攻击风险等。

从本次会议看,人工智能安全可谓在对抗中前进:人工智能除了要解决用户关注的隐私合规问题外,还需要解决AI对抗类攻击。以智能对抗智能是当前对抗AI类攻击的主要手段,而如何在对抗中“获得先手”,获取防御主动地位,是AI安全要解决的核心问题,也是安全攻防的痛点。

原文标题:RSAC2022解读丨人工智能安全洞察—在对抗中前进

文章出处:【微信公众号:华为数据通信】欢迎添加关注!文章转载请注明出处。

-

API

+关注

关注

2文章

1381浏览量

60986 -

AI

+关注

关注

87文章

26423浏览量

264024 -

机器学习

+关注

关注

66文章

8116浏览量

130546

原文标题:RSAC2022解读丨人工智能安全洞察—在对抗中前进

文章出处:【微信号:Huawei_Fixed,微信公众号:华为数据通信】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

防止AI大模型被黑客病毒入侵控制(原创)聆思大模型AI开发套件评测4

使用cube-AI分析模型时报错的原因有哪些?

谷歌模型合成工具怎么用

如何使用Dioptra工具进行AI模型的加固

如何使用Dioptra工具进行AI模型的加固

评论