最新MLPerf基准测试表明,NVIDIA已将其在AI推理性能和能效方面的高标准扩展到Arm以及x86计算机。

2021-09-23 14:18:06 2518

2518

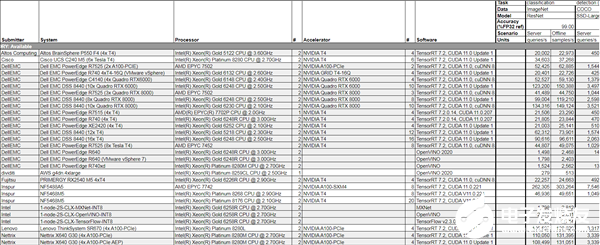

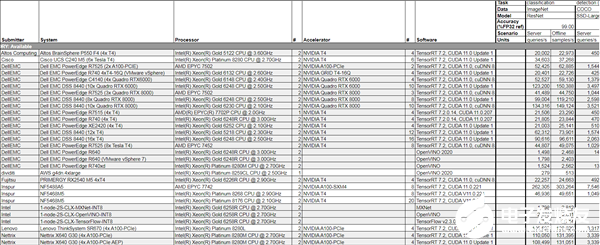

不久前,AI性能基准评测平台MLPerf公布了2022年首次推理(Inference v2.0)测试成绩,NVIDIA的AI平台表现依然抢眼。

2022-04-15 22:12:00 2738

2738

NVIDIA Turing GPU和Xavier 芯片系统在首个独立AI推理基准测试 ——MLPerf Inference 0.5中取得第一名。

2019-11-08 16:53:29 5054

5054 NVIDIA凭借A100进一步扩大了在MLPerf基准测试中的领先优势,实现了比CPU快237倍的AI推理性能,助力企业将AI研究转化为生产力。

2020-10-22 14:07:58 714

714 NVIDIA NeMo Megatron 框架; 可定制的大规模语言模型 Megatron 530B;多GPU、多节点 Triton推理服务器助力基于语言的AI开发和部署,推动行业和科学发展。

2021-11-10 14:22:52 752

752 Windows Server 2016许可证服务器上获取并安装了环境的NVIDIA Virtual Applications许可证。选择虚拟应用程序许可证的决定基于使用XenApp(已发布的应用程序/桌面

2018-09-25 17:32:49

虽然GPU解决方案对训练,AI部署需要更多。

预计到2020年代中期,人工智能行业将增长到200亿美元,其中大部分增长是人工智能推理。英特尔Xeon可扩展处理器约占运行AI推理的处理器单元的70

2023-08-04 07:25:00

首发极术社区如对Arm相关技术感兴趣,欢迎私信 aijishu20加入技术微信群。分享内容NVIDIA Jetson是嵌入式计算平台,具有低功耗、高性能和小体积等特点,可加速各行业的AI应用落地

2021-12-14 08:05:01

此次测试的十二家公司中,只有NVIDIA AI平台提交了 MLPerf的全部五项推理测试成绩(MLPerf是一个于2018年5月成立的行业基准测试小组)。这证明了NVIDIA CUDA-X AI

2019-11-08 19:44:51

我们计划使用2台Nvidia Tesla M60显卡进行远程管理,并可选择进一步扩展,使用HP Apollo 2600服务器。据我了解,要部署远程虚拟管理,我们需要Nvidia GRID程序

2018-09-13 17:08:32

客户在其环境中拥有nVidia Licensing服务器(vSphere Enterprise Plus和Horizon 7)。许可证文件在nVidia企业门户中生成,并且许可证服务器中安装了2

2018-09-20 11:41:44

嗨,我想知道,如果可以安装NVIDIA许可证服务器吗?我没有找到任何关于此的明确文件。 setup.exe也没有我能够使用的任何清晰的开关/参数。谢谢,延以上来自于谷歌翻译以下为原文Hi, I

2018-09-18 16:18:10

基于SRAM的方法可加速AI推理

2020-12-30 07:28:28

Tengine是什么?如何在RK3399这一 Arm64 平台上搭建 Tengine AI 推理框架,并运行图像识别相关应用?

2022-03-07 07:53:43

Tengine是什么呢?如何在RK3399这一 Arm64平台上搭建Tengine AI推理框架呢?

2022-03-04 12:31:35

1 简介AI任务管理与统一的推理能力提供了接口的统一标准系统上CPU提供了AI任务调度管理的能力,对AI的能力进行了开放的推理和推理,同时,提供了一个不同的生命周期框架层级的应用程序。推理接口

2022-03-25 11:15:36

商业发行之前就已经过时了。算法明天需要对架构、内存/数据进行彻底改革资源和能力。推理的梦幻建筑重新定义重写在计算和交付突破性的人工智能加速和灵活的计算能力超越了服务器级CPU和比GPU/ASIC通用

2020-11-01 09:28:57

为帮助数据科学家和开发人员充分利用深度学习领域中的机遇,NVIDIA为其深度学习软件平台发布了三项重大更新,它们分别是NVIDIA DIGITS 4、CUDA深度神经网络库(cuDNN)5.1和全新的GPU推理引擎(GIE)。

NVIDIA深度学习软件平台推三项重大更新

2016-08-06 15:00:26 1806

1806 MLPerf Inference 0.5是业内首个独立AI推理基准套件,其测试结果证明了NVIDIA Turing数据中心GPU以及 NVIDIA Xavier 边缘计算芯片系统的性能。

2019-11-29 14:45:02 2696

2696 2019年12月18日— — NVIDIA于今日发布一款突破性的推理软件。借助于该软件,全球各地的开发者都可以实现会话式AI应用,大幅减少推理延迟。而此前,巨大的推理延迟一直都是实现真正交互式互动的一大阻碍。

2019-12-19 10:06:51 1045

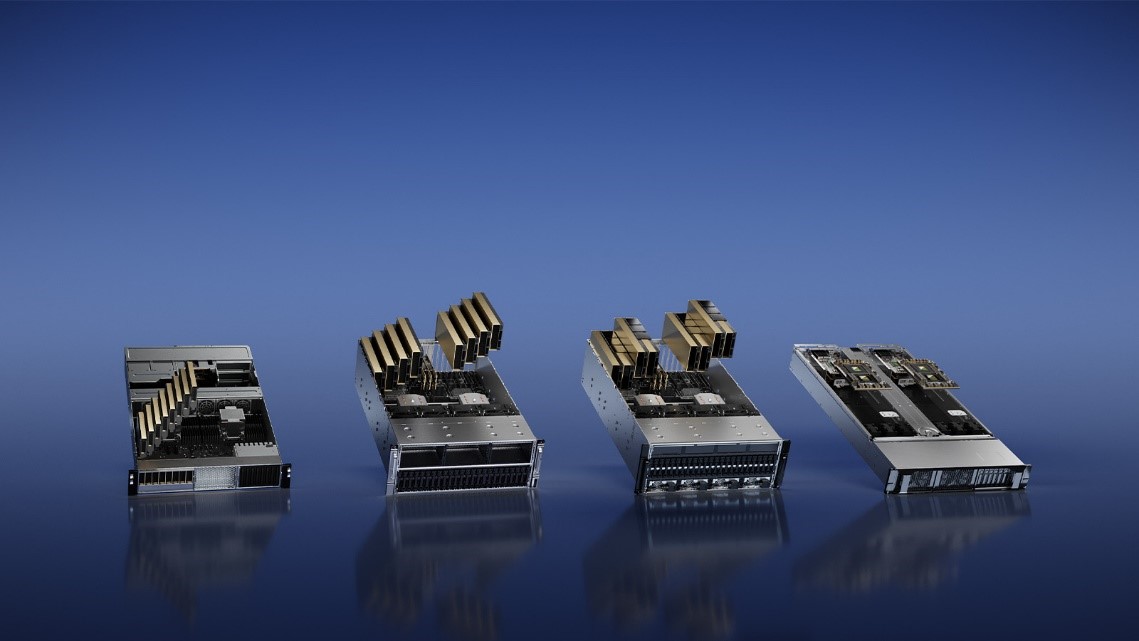

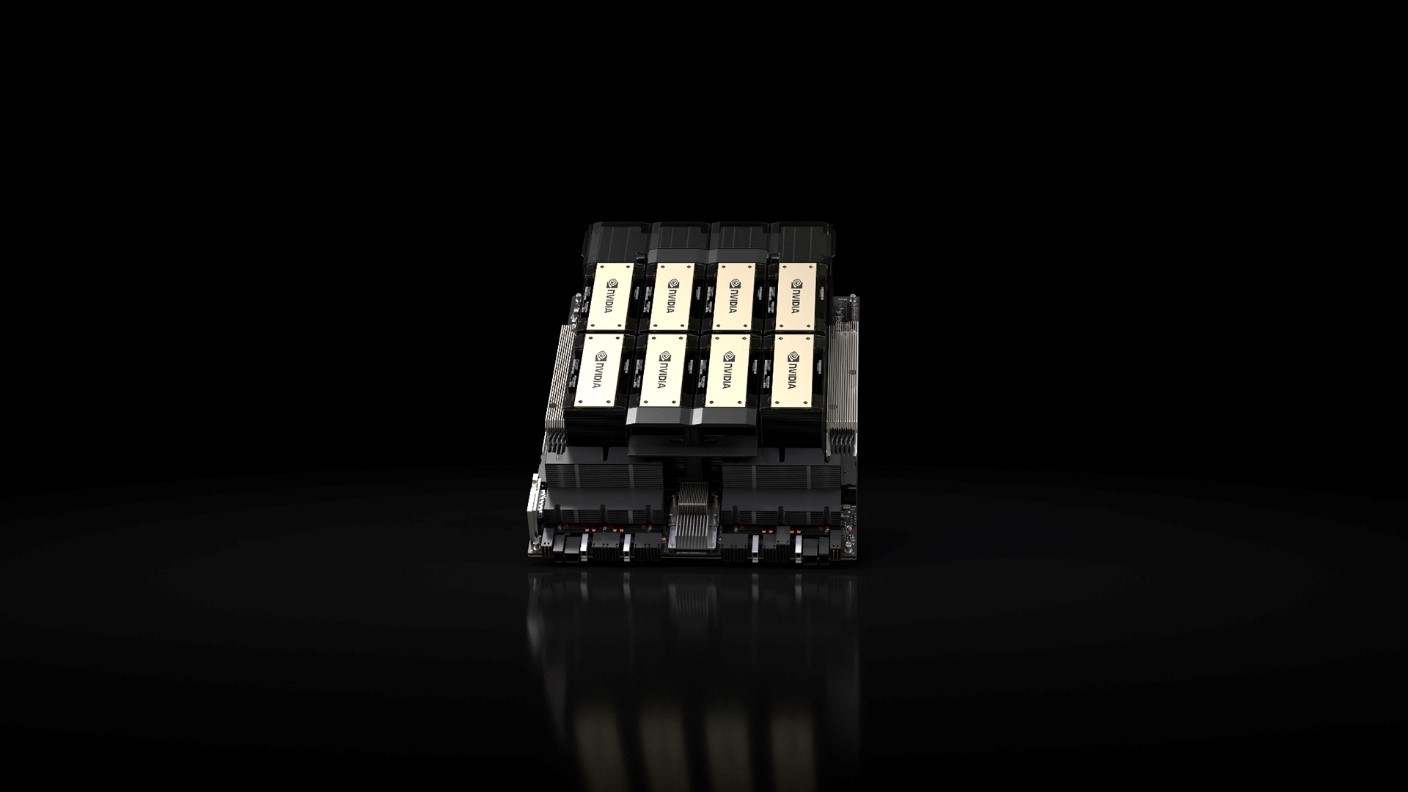

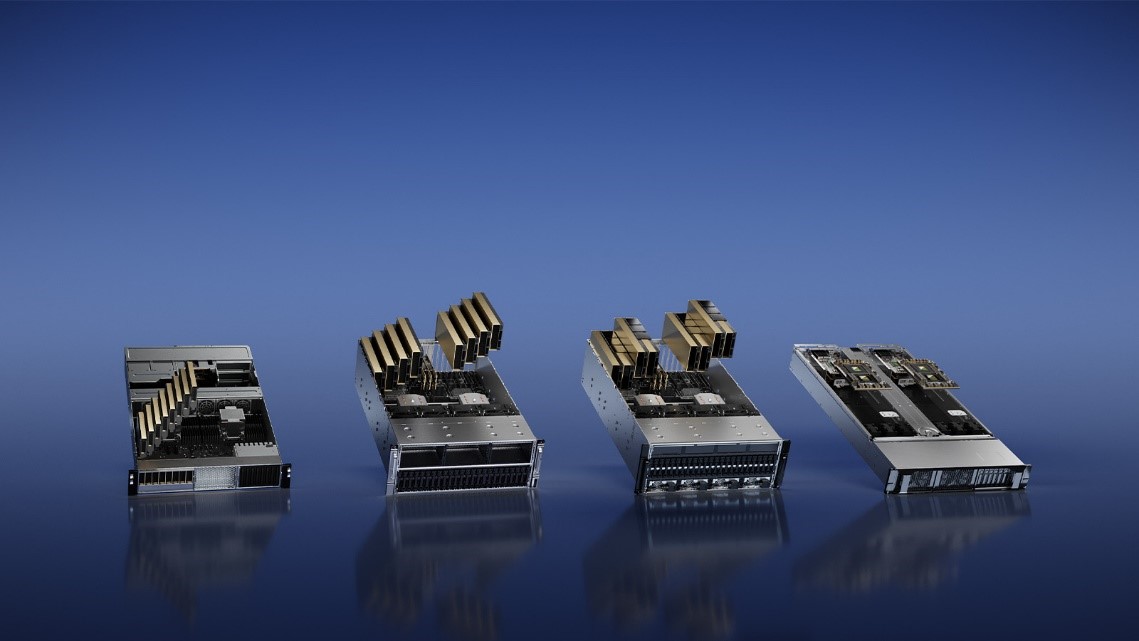

1045 了全球超强大的AI和HPC服务器平台HGX A100,最大可组成AI算力达10 PFLOPS的超大型服务器。

2020-06-02 17:11:45 3709

3709 NVIDIA和多家全球领先的服务器制造商于今日发布多款内置NVIDIA A100的系统。这些系统具有多种不同的设计和配置,可应对AI、数据科学和科学计算领域最复杂的挑战。

2020-06-24 16:04:33 2585

2585 这些AI模型被运行在装载了V100Tensor Core GPU的NVIDIADGX系统上的数据中心服务器上,以及装载了JetsonAGX Xavier模块的边缘计算网络中。该硬件运行NVIDIA

2020-07-02 15:00:54 1819

1819 )的12个提交者增加了近一倍。 结果显示,今年5月NVIDIA(Nvidia)发布的安培(Ampere)架构A100 Tensor Core GPU,在云端推理的基准测试性能是最先进Intel CPU

2020-10-23 17:40:02 3929

3929

芯东西1月27日报道,刚刚,NVIDIA公布通过NVIDIA认证系统测试的全球首批加速服务器,它们是目前业内唯一通过现代工作负载测试的服务器,可用于机器学习和分析。 通过NVIDIA认证系统的产品

2021-01-27 16:25:59 1716

1716 领导者 Equinix 将首先加入 AI LaunchPad 程序,其将通过 Platform Equinix 平台向全球提供由 NVIDIA 支持的混合云解决方案。Equinix 基础设施在几分钟内就能部

2021-06-24 17:35:50 2095

2095 NVIDIA于今日发布公司第八代AI软件TensorRT™ 8。该软件将语言查询推理时间缩短了一半,使开发者能够从云端到边缘构建全球最佳性能的搜索引擎、广告推荐和聊天机器人。

2021-07-21 15:07:57 3208

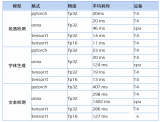

3208 自然语言理解、匹配排序等等,这些模型的训练和推理都大量依赖于NVIDIA GPU,尤其在推理方面,NVIDIA GPU及相应的解决方案都满足了业务所需的延迟和吞吐要求。 微信搜索业务需要更高效平台 微信搜索业务由多个子模块构成,包括查

2021-10-28 15:28:12 1551

1551 NVIDIA NeMo Megatron 框架; 可定制的大规模语言模型Megatron 530B;多GPU、多节点 Triton推理服务器助力基于语言的AI开发和部署,推动行业和科学发展

2021-11-12 14:30:07 1327

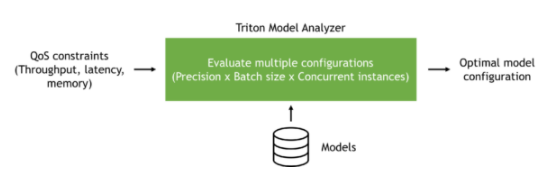

1327 Capital One、Microsoft、Samsung Medison、Siemens Energy、Snap等25000多家客户都在使用该平台。 这些更新包括开源NVIDIA Triton推理服务器

2021-11-12 14:42:53 1684

1684 平台),NVIDIA和Mavenir 正在实现智能边缘网络构建方式的创新。企业和电信公司能够利用配备聚合加速器的边缘服务器快速部署各种AI 技术,例如同时部署NVIDIA Metropolis智

2021-11-15 14:25:56 2108

2108 。 符合条件的企业可以体验用于AI开发的NVIDIA Base Command云服务、用于AI部署的NVIDIA F

2021-11-15 15:14:50 1546

1546 西门子能源公司正在发挥 NVIDIA Triton 推理服务器的强大力量,利用 AI 协助解决全球发电厂在预测性服务管理方面的担忧。

2021-11-16 16:25:31 3490

3490 Microsoft Teams借助AI生成的实时字幕和转录功能,帮助全球学生和职场人士顺利进行在线会议。用于训练的NVIDIA AI计算技术和用于推理语音识别模型的NVIDIA Triton推理服务器进一步提升了这两个功能。

2022-01-04 14:20:11 1407

1407 Microsoft Teams借助AI生成的实时字幕和转录功能,帮助全球学生和职场人士顺利进行在线会议。用于训练的NVIDIA AI计算技术和用于推理语音识别模型的NVIDIA Triton推理服务器进一步提升了这两个功能。

2022-01-04 17:45:12 1472

1472 NVIDIA AI 可供开发者免费使用,包括用于语音 AI 的 NVIDIA Riva 和用于智能推荐系统的 NVIDIA Merlin™,这两款软件均已正式全面上线。而整个软件套件也进行了更新,包括 NVIDIA Triton、NeMo、Maxine 和 TAO 工具包等工具。

2022-03-23 14:27:08 1058

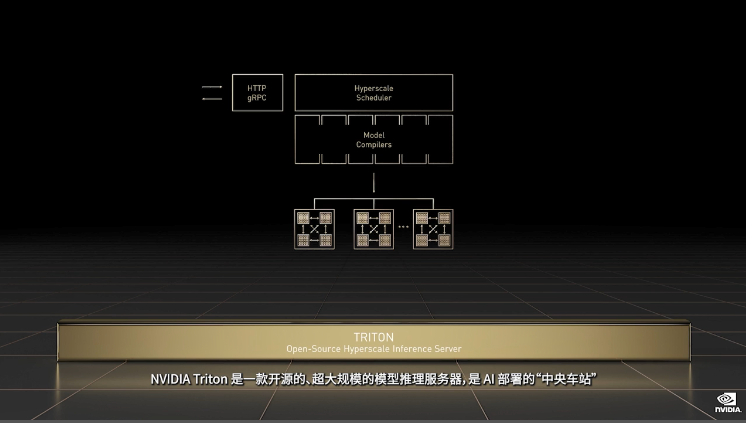

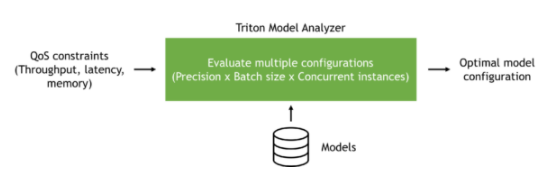

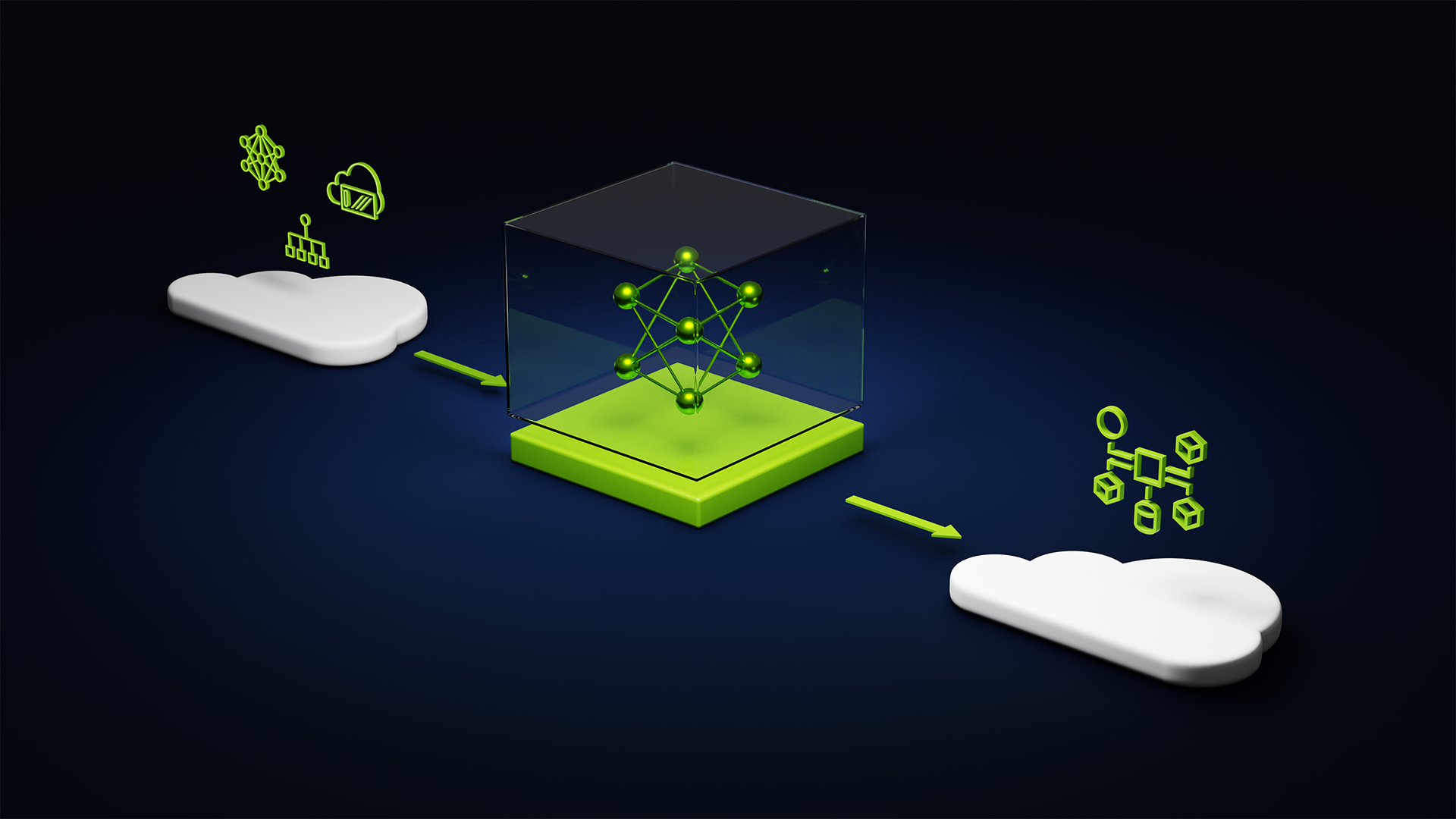

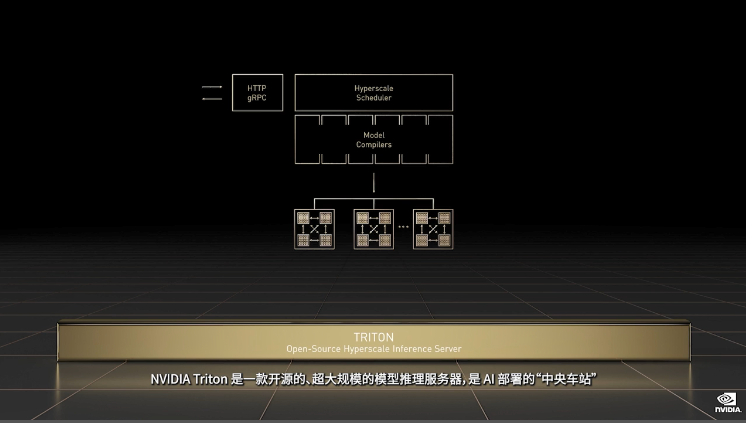

1058 GTC2022大会黄仁勋:NVIDIA Triton是AI部署的“中央车站”,支持在每一代NVIDIA GPU、x86和ARM CPU上部署模型。

2022-03-23 16:23:04 1259

1259

Microsoft 的目标是,通过结合使用 Azure 与 NVIDIA GPU 和 Triton 推理软件,率先将一系列强大的 AI Transformer 模型投入生产用途。

2022-03-28 09:43:38 1029

1029 推荐系统的大规模部署带来了诸多工程化挑战,借助NVIDIA TensorRT, Triton and MPS (Multi-Process Service) 及单张T4 GPU推理卡,其性能优于约6台以上的78核CPU服务器,成本方面也降低75%。

2022-03-29 15:25:05 1106

1106 TensorRT 是一款高性能的深度学习推理优化器和运行时,为人工智能应用程序提供低延迟、高吞吐量推理。 TensorRT 用于医疗、汽车、制造、互联网/电信服务、金融服务和能源等多个行业。

2022-03-31 17:10:29 1469

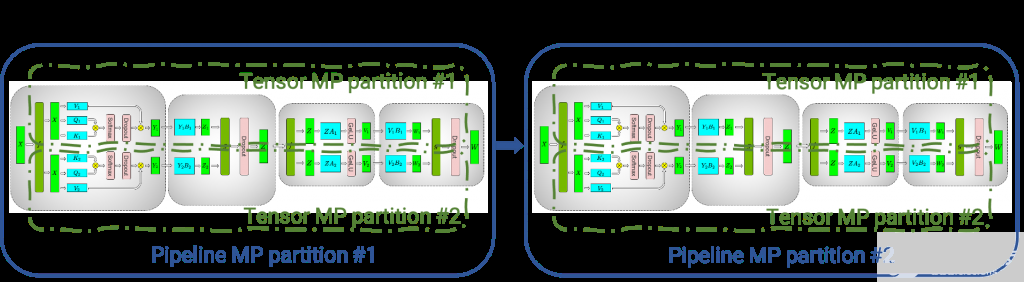

1469 它包括Megatron方面的进步,这是一个由 NVIDIA 研究人员领导的开源项目,旨在开发有效培训法学硕士的技术。企业可以使用 NeMo Megatron 定制 LLM ,如 Megatron 530B ,并使用 NVIDIA Triton 推理服务器跨多个 GPU 和节点进行部署。

2022-04-01 16:27:36 10987

10987 Microsoft 的目标是,通过结合使用 Azure 与 NVIDIA GPU 和 Triton 推理软件,率先将一系列强大的 AI Transformer 模型投入生产用途。

2022-04-02 13:04:21 1456

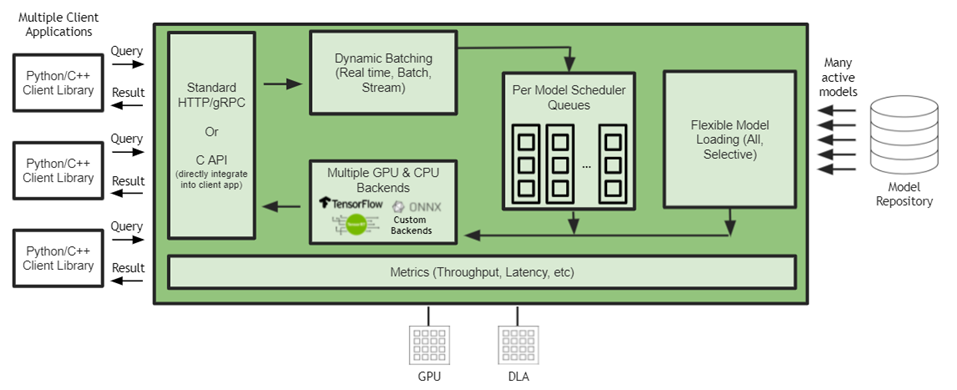

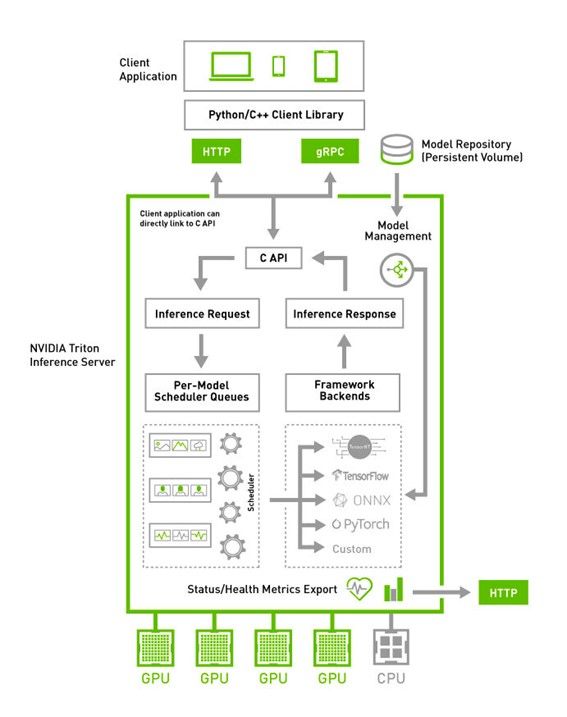

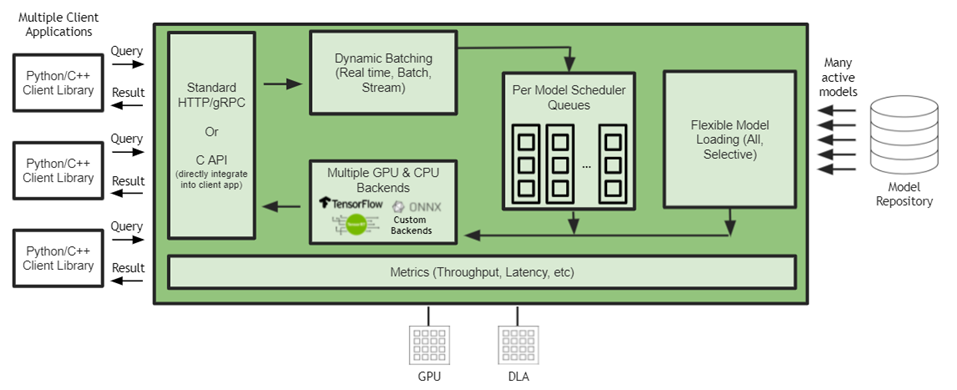

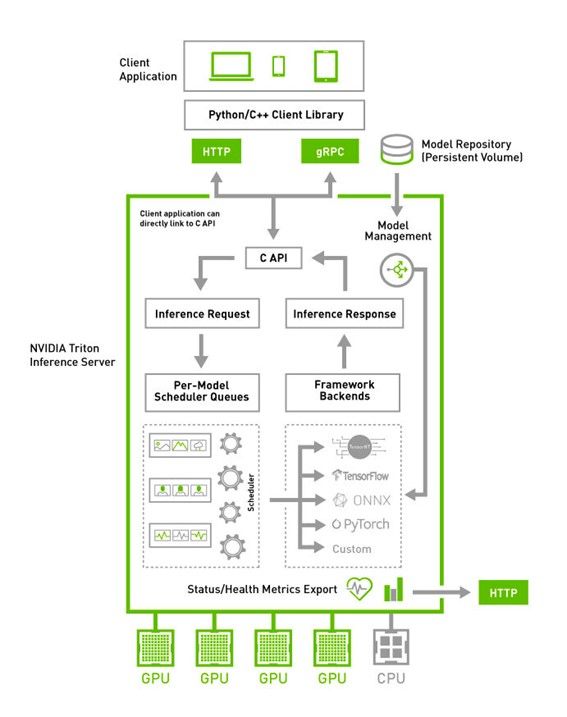

1456 NVIDIA Triton 推理服务器是一款开源人工智能模型服务软件,可简化在生产中大规模部署经过培训的人工智能模型。对于服务器管理的任何模型,客户端可以远程向提供的 HTTP 或 gRPC 端点发送推断请求。

2022-04-07 09:54:05 2902

2902 对于 AWS 上的人工智能推理部署,您可以利用 NVIDIA Triton 推理服务器 。使用开源推理服务软件在任何 CPU 或 CPU 基础设施上部署来自多个框架的经过培训的人工智能模型,包括 TensorFlow 、 TensorRT 、 PyTorch 、 ONNX 、 XGBoost 和 Python 。

2022-04-08 15:37:28 881

881 现在,您和开发人员社区的其他成员都可以使用这些成果,主要是以开源软件的形式。此外, TensorRT 和 Triton 推理服务器可从 NVIDIA NGC 免费获得,以及预训练模型、深度学习框架

2022-04-08 16:31:31 931

931

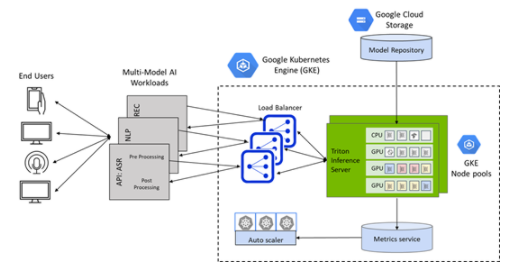

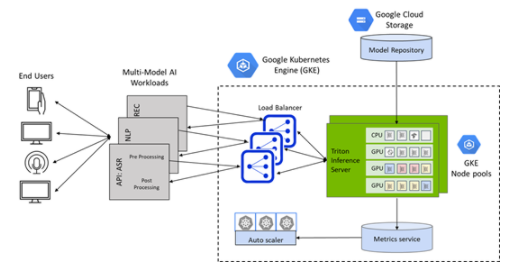

GKE 的 Triton 推理服务器应用程序是一个 helm chart 部署程序,可自动安装和配置 Triton ,以便在具有 NVIDIA GPU 节点池的 GKE 集群上使用,包括

2022-04-08 16:43:03 1855

1855

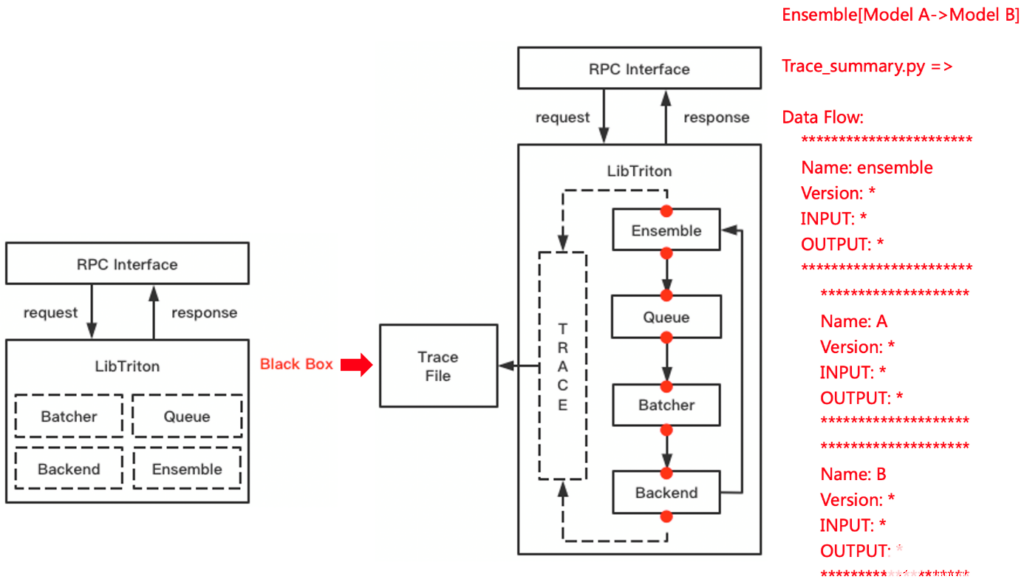

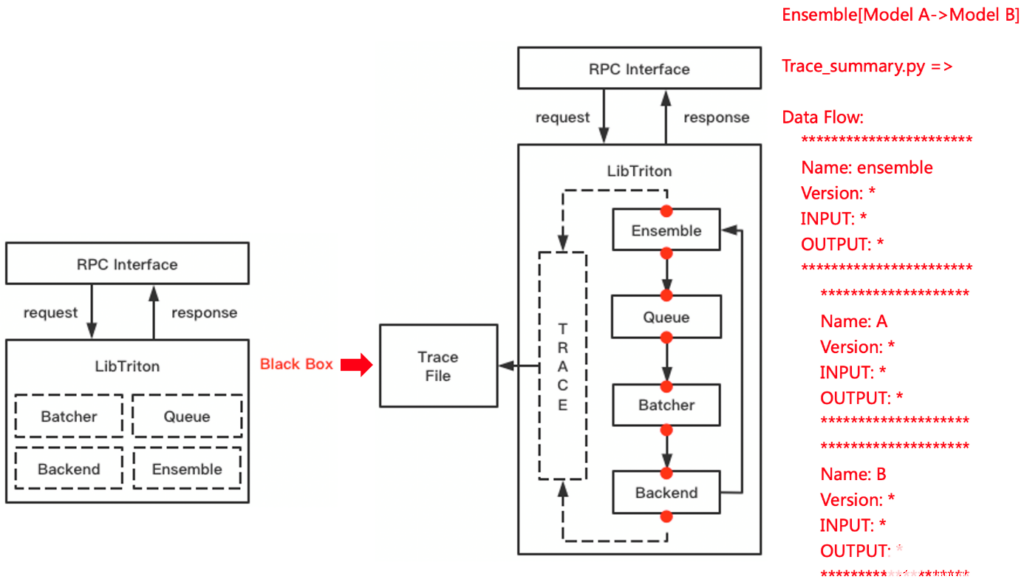

通过将 Triton 编译为动态链接库,可以方便地链入公司内部框架,对接公司的平台治理体系。符合 C 语言规范的 API 也极大降低了用户的接入成本。

2022-04-10 10:08:31 1104

1104 一个完整的医疗影像推理流程一般包含数据的前处理、AI 推理以及数据后处理这几部分。

2022-04-10 15:06:09 2396

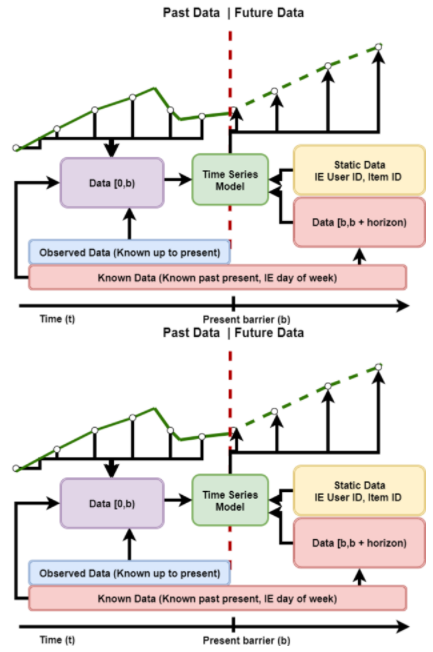

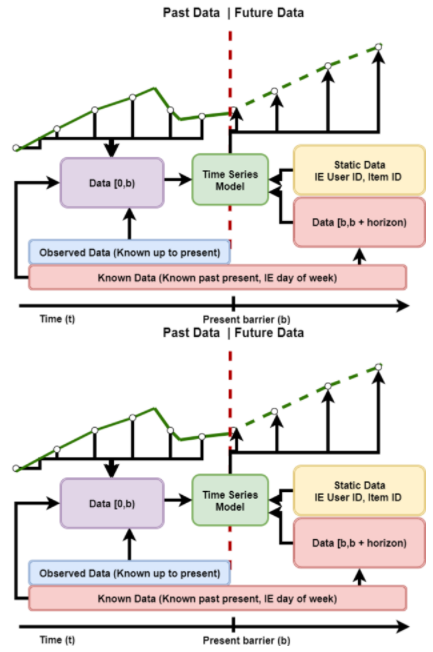

2396 NVIDIA 时间序列预测平台提供从训练到时间序列模型的推断的端到端 GPU 加速。平台中包含的参考示例经过优化和认证,可在 NVIDIA DGX A100 和 NVIDIA 认证系统上运行。

2022-04-10 17:44:04 1762

1762

使用 FIL 后端,NVIDIA Triton 推理服务器现在提供了一个高度优化的实时服务的森林模型,无论是在他们自己或旁边的深度学习模型。

2022-04-11 14:35:54 1138

1138

“在使用 NVIDIA TensorRT和NVIDIA T4 GPU对平台赋能后,“极星”推理平台的算法推理效率得到了进一步的提升,更好地支持速接入各类算法、数据及智能设备,实现AI自闭环能力,并通过应用服务和标准化接口,帮助终端客户低成本实现AI与业务的结合,快速构建智能应用。

2022-04-13 14:49:19 862

862 NVIDIA Triton 有助于在每个数据中心、云和嵌入式设备中实现标准化的可扩展生产 AI 。它支持多个框架,在 GPU 和 DLA 等多个计算引擎上运行模型,处理不同类型的推理查询。通过与 NVIDIA JetPack 的集成, NVIDIA Triton 可用于嵌入式应用。

2022-04-18 15:40:02 2306

2306

网易互娱 AI Lab 的研发人员,基于 Wenet 语音识别工具进行优化和创新,利用 NVIDIA Triton 推理服务器的 GPU Batch Inference 机制加速了语音识别的速度,并且降低了成本。

2022-05-13 10:40:19 1481

1481 借助NVIDIA Triton 推理框架,配合 DALI/FIL/Python 等Backend,以及 TensorRT,整体推理服务的吞吐能力最大提升 6 倍,延迟最大降低 40%。

2022-05-20 15:25:10 2131

2131

在这篇文章中,我们使用预训练 BERT Hugging Face 的大型模型,采用 PyTorch 格式。 NVIDIA Triton 推理服务器可以使用其LibTorch后端为TorchScript模型提供服务,也可以使用其 Python 后端为纯 PyTorch 模型提供服务。

2022-05-30 09:38:08 2378

2378

使用 NVIDIA Triton ®声波风廓线仪,爱夏可在数据中心使用高性能 GPU 或在靠近数据的边缘使用 Jetson 边缘 AI 平台部署预训练模型的优化版本。

2022-05-30 09:46:57 609

609

NVIDIA Triton 推理服务器(以前称为 TensorRT 推理服务器)是一款开源软件,可简化深度学习模型在生产环境中的部署。借助 Triton 推理服务器,Devops 和 MLops

2022-06-28 15:49:47 1293

1293 NVIDIA Triton 推理服务器在 NVIDIA T4 GPU 上进行高效部署,帮助阿里巴巴天猫精灵流式 TTS 服务将吞吐提升 50%,首包延时降低 35%,大幅提升服务运行效率,提升资源利用率。

2022-07-14 10:05:00 817

817 NVIDIA Triton 推理服务器是 NVIDIA AI 平台的一部分,它是一款开源推理服务软件,可助力标准化模型的部署和执行,并在生产环境中提供快速且可扩展的 AI。

2022-07-18 10:11:26 2525

2525 腾讯云计算加速套件 TACO Kit 包含 TACO Train 和 TACO Infer 两个 AI 组件。基于 GPU 异构计算平台针对业界 AI 训练和推理任务进行了全方位的加速优化。TACO

2022-08-31 09:24:07 1235

1235 腾讯云 TI 平台 TI-ONE 利用 NVIDIA Triton 推理服务器构造高性能推理服务部署平台,使用户能够非常便捷地部署包括 TNN 模型在内的多种深度学习框架下获得的 AI 模型,并且显著提升推理服务的吞吐、提升 GPU 利用率。

2022-09-05 15:33:01 1419

1419 蚂蚁链 AIoT 团队与 NVIDIA 合作,将量化感知训练(QAT)技术应用于深度学习模型性能优化中,并通过 NVIDIA TensorRT 高性能推理 SDK 进行高效率部署, 通过 INT8 推理, 吞吐量提升了 3 倍, 助力蚂蚁链版权 AI 平台中的模型推理服务大幅降本增效。

2022-09-09 09:53:52 872

872 在近日举行的 GTC 大会上,蔚来 AI 平台负责人白宇利带来非常有价值的分享,他首次对外透露了蔚来自研的全栈式自动驾驶系统(NAD)的部署和开发情况,同时也将蔚来自动驾驶研发平台(NADP)这个神秘的“Peta Factory”带到了公众视野中。

2022-10-09 10:18:20 661

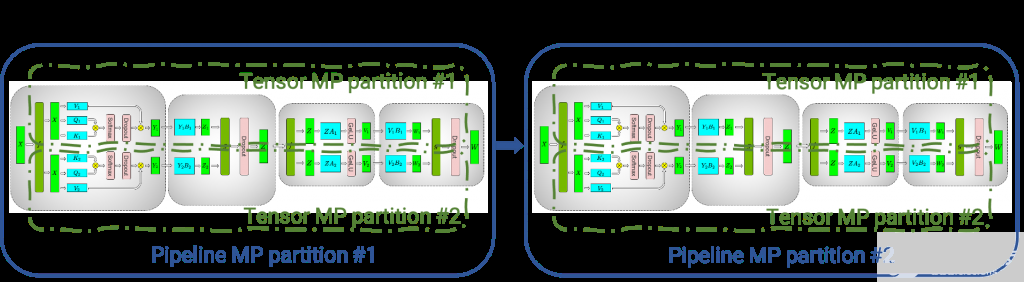

661 这是讨论 NVIDIA FasterTransformer 库的两部分系列的第一部分,该库是用于对任意大小(多达数万亿个参数)的Transformer进行分布式推理的最快库之一。它提供了 FasterTransformer 的概述,包括使用该库的好处。

2022-10-10 16:07:48 1067

1067

Triton 为高效的多模型推理带来了一种新的模型编排服务。该软件应用程序目前处于早期使用阶段,有助于以资源高效的方式简化 Kubernetes 中 Triton 实例的部署,其中包含许多模型。此服务的一些关键功能包括:

2022-10-11 14:24:32 972

972

蔚来自动驾驶研发平台(NADP)是着力服务于自动驾驶核心业务方向的研发平台。平台化的推理能力作为常规机器学习平台的重要组成部分,也是NADP所重点建设和支持的能力之一。 NADP所支持的推理业务,整体上有以下几个特性:

2022-10-12 09:32:29 724

724

NVIDIA 张量RT 是一个高性能推理平台,对于利用 NVIDIA 张量核心 GPU 的强大功能至关重要。TensorRT 8 是一个具有增强功能的软件开发工具包,旨在提高性能和准确性,以应对边缘和嵌入式设备中发生的越来越多的 AI 推理。它允许对张量流和PyTorch神经网络进行广泛的计算推断。

2022-10-18 09:32:46 390

390 通过 NVIDIA GPU 加速平台,Colossal-AI 实现了通过高效多维并行、异构内存管理、大规模优化库、自适应任务调度等方式,更高效快速部署 AI 大模型训练与推理。

2022-10-19 09:39:39 1149

1149 推理识别是人工智能最重要的落地应用,其他与深度学习相关的数据收集、标注、模型训练等工作,都是为了得到更好的最终推理性能与效果。

2022-10-26 09:43:57 1370

1370 前面文章介绍微软 Teams 会议系统、微信软件与腾讯 PCG 服务三个 Triton 推理服务器的成功案例,让大家对 Triton 有初步的认知,但别误以为这个软件只适合在大型的服务类应用中使用,事实上 Triton 能适用于更广泛的推理环节中,并且在越复杂的应用环境中就越能展现其执行成效。

2022-11-02 10:44:41 1813

1813 与 Getting Started 属于入门范畴,其余 User Guide、API Guide、Additional Resources 与 Customization Guide 等四个部分,都是 Triton 推理服务器非常重要的技术内容。

2022-11-09 16:17:46 506

506 推理模型仓(inference model repository) 是 Triton 推理服务器的最基础元件 ,如同数据库(database)服务器必须先创建一个数据库是类似的道理。要使

2022-11-15 21:20:12 589

589 在前一篇文章已经带着读者创建一个 Triton 的推理模型仓,现在只要安装好服务器端与用户端软件,就能进行基本的测试与体验。 为了简化过程,我们使用 NVIDIA Jetson AGX Orin

2022-11-22 19:50:02 882

882 在前面的文章中,已经带着读者创建好 Triton 的模型仓、安装并执行 Triton 推理服务器软件,接下来就是要 安装 Triton 用户端软件,对服务器提出推理请求(requests),才能触发

2022-11-29 19:20:06 751

751 模型,并提供开箱即用的云边端部署体验,实现 AI 模型端到端的推理性能优化。 欢迎广大开发者使用 NVIDIA 与飞桨联合深度适配的 NGC 飞桨容器,在 NVIDIA GPU 上进

2022-12-13 19:50:05 909

909 的材料,处理起来是很容易的,比较复杂的部分是配置文件 config.pbtxt 的内容,里面提供 Triton 服务器用来管理模型执行特

2022-12-27 21:20:07 715

715 前面已经做好了每个推理模型的基础配置,基本上就能正常让 Triton 服务器使用这些独立模型进行推理。接下来的重点,就是要让设备的计算资源尽可能地充分使用,首先第一件事情就是模型并发执行

2023-01-05 11:55:06 637

637 本案例中,vivo 人工智能推荐算法组自研的推荐服务平台,使用阿里巴巴开源大规模稀疏模型训练和预测引擎 DeepRec,在稀疏模型训练(稀疏功能、I/O 优化)和高性能推理框架层面,实现其搜广推各类

2023-01-18 00:55:01 548

548 、NVIDIA 的技术专家将带来 AI Infra 、 推理引擎 相关的专题分享,包括目前各企业面临的模型推理挑战、Triton 的应用及落地的具体方案等,现身说法,干货十足。此外,还有来自

2023-02-15 16:10:05 207

207 从元宇宙到AIGC,全球AI热潮迭起,拉动巨大算力需求。作为AI与元宇宙全球盛会,于3月20-23日举行的NVIDIA GTC将展示这一轮新的全球技术变革。 宁畅X620 G50全能型AI服务器率先

2023-03-22 14:27:49 525

525

日 – NVIDIA于今日推出四款推理平台。这些平台针对各种快速兴起的生成式AI应用进行了优化,能够帮助开发人员快速构建用于提供新服务和洞察的AI驱动的专业应用。 这些平台将NVIDIA的全栈推理

2023-03-22 14:48:39 256

256

日 – NVIDIA 于今日推出四款推理平台。这些平台针对各种快速兴起的生成式 AI 应用进行了优化,能够帮助开发人员快速构建用于提供新服务和洞察的 AI 驱动的专业应用。 这些平台将 NVIDIA

2023-03-23 06:55:02 654

654 NVIDIA 生成式 AI 推理平台将集成至谷歌云 Vertex AI 中;谷歌云成为首家提供 NVIDIA L4 GPU 实例的云服务商 加利福尼亚州圣克拉拉 – GTC – 太平洋时间 2023

2023-03-23 06:55:02 438

438 NVIDIA在3月23日周四举行的全球AI和元宇宙大会GTC上发布了多项引爆新一轮视觉AI热潮的技术更新,包括用于创建自定义生产级AI模型的NVIDIA TAO工具套件5.0、用于开发视觉AI应用和服务的软件开发工具套件NVIDIA DeepStream扩展...

2023-03-27 16:57:40 927

927

的第三方基准测试,MLPerf 仍是衡量 AI 性能的权威标准。自 MLPerf 诞生以来,NVIDIA 的 AI 平台在训练和推理这两个方面一直展现出领先优势,包括最新发布的 MLPerf

2023-04-08 00:30:08 389

389 案例介绍 金山办公与 NVIDIA 团队合作,通过 NVIDIA Tensor Core GPU、TensorRT 提升图像文档识别与理解的推理效率;借助 NVIDIA Triton 推理服务器

2023-06-29 21:35:04 366

366

使用集成模型在 NVIDIA Triton 推理服务器上为 ML 模型管道提供服务

2023-07-05 16:30:34 1082

1082

OVX 服务器采用全新 NVIDIA GPU 以加速训练和推理以及图形密集型工作负载,将通过戴尔科技、慧与、联想、超微等公司提供。 洛杉矶 — SIGGRAPH — 太平洋时间 2023

2023-08-09 19:10:06 264

264 这些性能强大的新系统将利用 NVIDIA Omniverse 平台加速高计算密集度的复杂应用,包括 AI 训练和推理、3D 设计和可视化、视频处理、工业数字化等。

2023-08-23 14:20:18 224

224 with NVIDIA 拉斯维加斯 — VMware Explore — 太平洋时间 2023 年 8 月 22 日 — NVIDIA 宣布,全球领先的系统制造商将推出 AI 就绪型服务器,其支持同发布的 VMware

2023-08-23 19:10:09 350

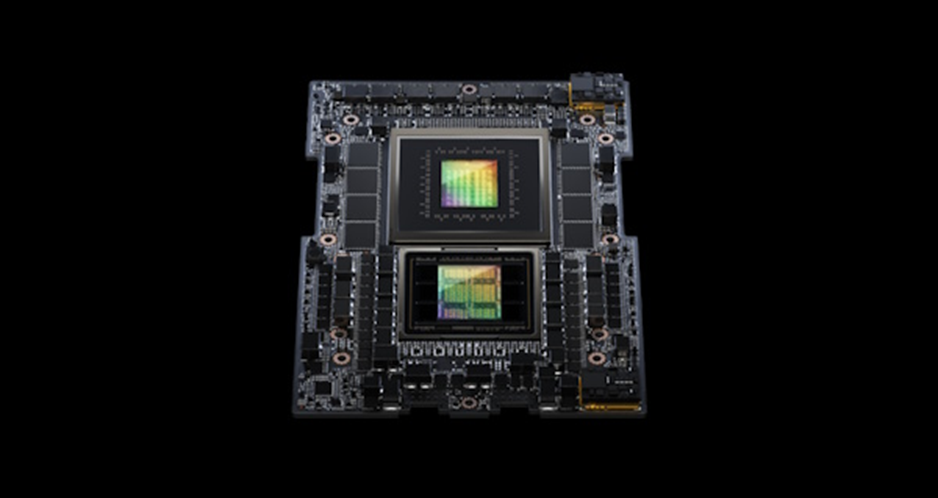

350 超级芯片 首次亮相 MLPerf 行业基准测试,其运行了所有数据中心推理测试,进一步扩大了 NVIDIA H100 Tensor Core GPU 的领先优势。 总体测试结果表明,NVIDIA AI

2023-09-12 20:40:04 249

249 Hopper超级芯片首次亮相 MLPerf 行业基准测试,其运行了所有数据中心推理测试,进一步扩大了NVIDIA H100 Tensor Core GPU的领先优势。 总体测试结果表明,NVIDIA AI

2023-09-13 09:45:40 139

139

,使用 NVIDIA Triton TM 推理服务器进行端到端部署 LLM Serving,以及金融行业的 AI、NLP/LLM 应用场景、客户案例。 通过本次活动,您将了解基于上述产品的 LLM

2023-10-26 09:05:02 174

174 NVIDIA HGX™ H200,为 Hopper 这一全球领先的 AI 计算平台再添新动力。NVIDIA HGX H200 平台基于 NVIDIA Hopper™ 架构,搭载 NVIDIA H200

2023-11-14 14:30:01 85

85

和初创公司在 Microsoft Azure 上开发、调优和部署其自定义生成式 AI 应用。 这项 NVIDIA AI foundry 服务整合了 NVIDIA AI Foundation

2023-11-16 14:13:08 116

116

AI Enterprise 软件进行部署 NVIDIA 于今日推出一项 AI foundry 服务,助力企业和初创公司在 Microsoft Azure 上开发、调优和部署其自定义生成式 AI

2023-11-16 21:15:02 270

270 本案例通过利用NVIDIA TensorRT-LLM加速指令识别深度学习模型,并借助NVIDIA Triton推理服务器在NVIDIA V100 GPU上进行高效部署,帮助必优科技的文档智能

2024-01-17 09:30:35 335

335 这家云计算巨头的计算机视觉和数据科学服务使用 NVIDIA Triton 推理服务器来加速 AI 预测。

2024-02-29 14:04:40 162

162

电子发烧友App

电子发烧友App

评论