美满电子科技(Marvell)今天宣布,中国搜索引擎巨头百度在全球首次商用的ARM架构服务器中,采用了Marvell公司的 ARM芯片组。作为世界范围内首家商用ARM服务器的公司,百度引领并开启了具有更低能耗和更高性能的全新“绿色数据中心”的新时代。

2013-02-26 11:04:02 1372

1372 Machine Learning SDK 相集成以供预览。客户可以使用 Azure 大规模部署的英特尔® FPGA(现场可编程逻辑门阵列)技术,为其模型提供行业领先的人工智能 (AI) 推理性能。

2018-05-16 17:25:03 6184

6184 Nvidia不太可能很快放弃目前在AI培训处理器市场上的领先优势,特别是考虑到它也在该领域投入巨资。虽然服务器推理处理器市场竞争更加激烈,但英特尔可能会成为与Nvidia和Xilinx一样强大的玩家。

2019-03-18 21:07:10 7659

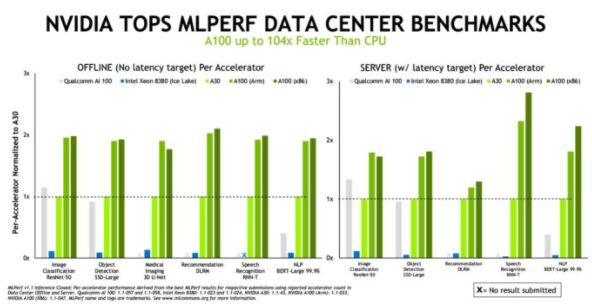

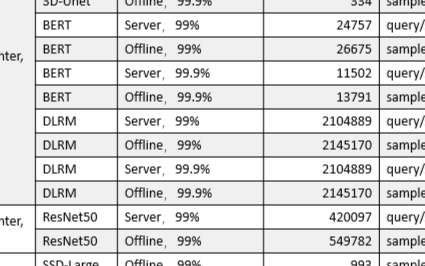

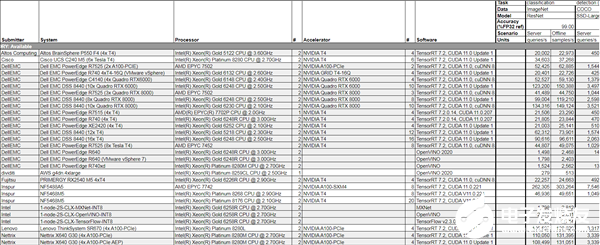

7659 不久前,AI性能基准评测平台MLPerf公布了2022年首次推理(Inference v2.0)测试成绩,NVIDIA的AI平台表现依然抢眼。

2022-04-15 22:12:00 2738

2738

NVIDIA Turing GPU和Xavier 芯片系统在首个独立AI推理基准测试 ——MLPerf Inference 0.5中取得第一名。

2019-11-08 16:53:29 5054

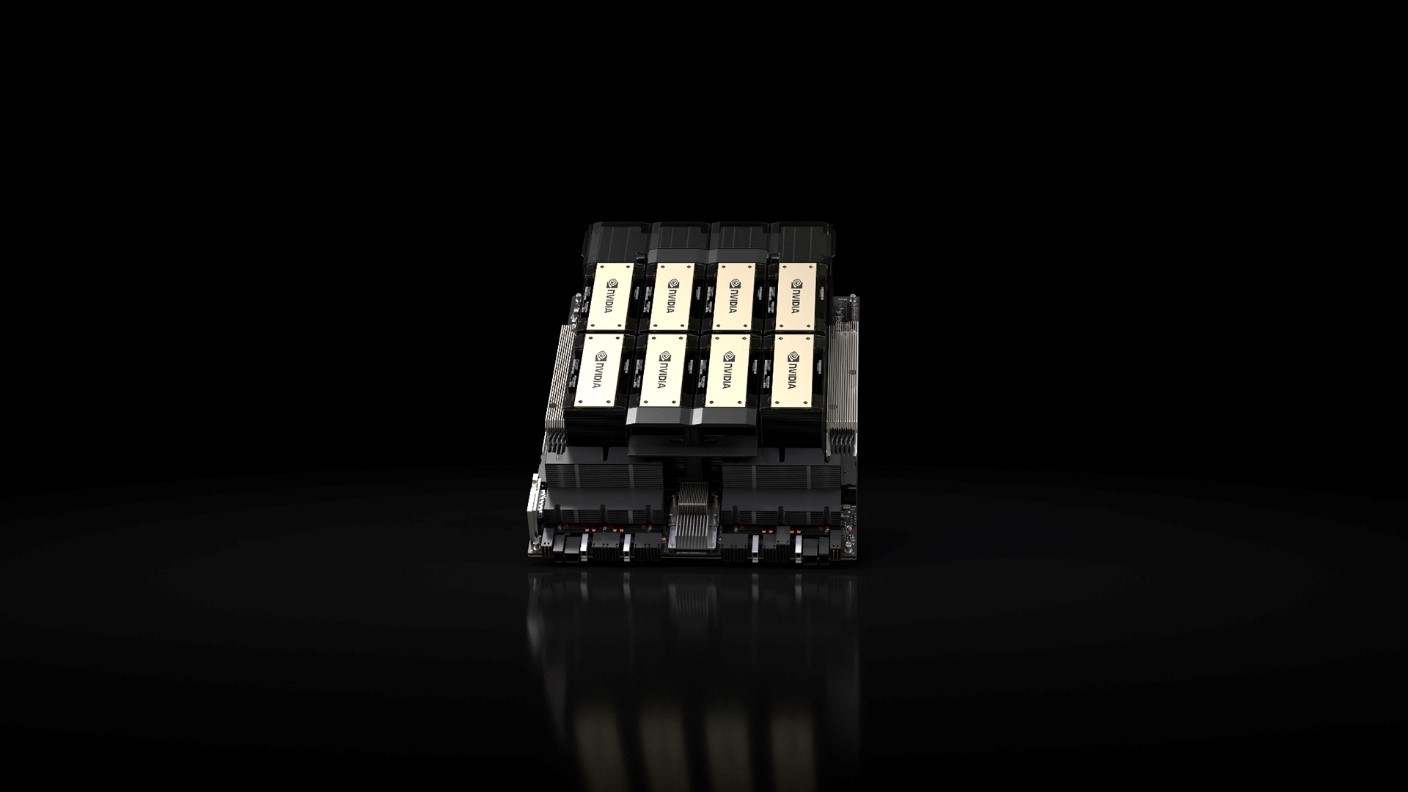

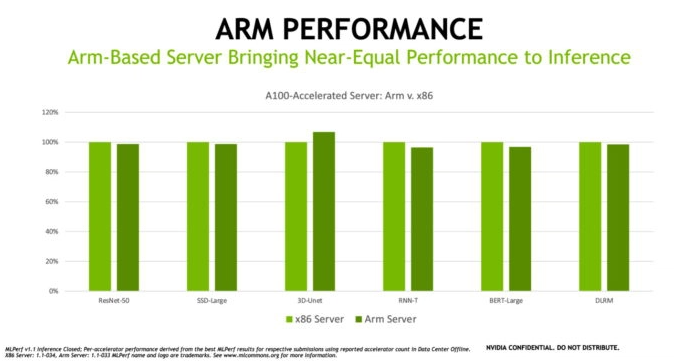

5054 NVIDIA与Arm、Ampere、Cray、富士通、HPE、Marvell携手构建GPU加速服务器,以满足从超大规模云到边缘、从模拟到AI、从高性能存储到百万兆级超级计算等多样化需求。

2019-11-20 09:38:42 1384

1384 NVIDIA凭借A100进一步扩大了在MLPerf基准测试中的领先优势,实现了比CPU快237倍的AI推理性能,助力企业将AI研究转化为生产力。

2020-10-22 14:07:58 714

714 宁畅工程师介绍,参加MLPerf Inference(推理)基准测试的X640 G30 AI服务器,最高可支持10张NVIDIA A100 PCIe卡或21张NVIDIA T4 PCIe卡,堪称“性能猛兽”。

2020-10-23 10:48:37 644

644 arm9linux系统平台:最近查ARM9上可以用的轻型WEB服务器 ,有BOA, HTTPD , THTTPD 等等,支持资源比较好的 是BOA ,但这种实现方式需要接入互联网,而且还可能集成

2022-10-28 10:53:39

和数据吞吐量进行优化的服务器和数据中心人工智能和机器学习 (ML) 的需求。否则,人工智能所需的成本、电力和碳将开始超过收益。NVIDIA 率先使用 GPU 来提高数据中心中 HPC 和 AI 的性能

2022-03-29 14:40:21

:具有 AWS Graviton3 处理器的 c7g.4xlarge 实例集群和具有 AWS Graviton2 处理器的 c6g.4xlarge 实例集群实现的 Resnet-50 v1.5 实时推理性能

2022-08-31 15:03:46

Cortex 三兄弟里最追求性能的了,但毕竟不是面向服务器平台的产品,不能放宽功耗限制去飙性能。于是,在Graviton 公开之前一个月,Arm 发布了面向云计算和边缘基础设施的 Neoverse

2022-09-08 14:32:42

的方式之一。作为通用的系统架构,Arm64服务器在多种数据中心应用场景都具有独特优势,如存储,大数据分析,高性能计算,物联网的边缘计算,Android应用,容器微服务等等。Arm64服务器基于开放的芯片

2018-06-03 13:20:30

首个独立AI推理基准测试 ——MLPerf Inference 0.5中取得第一名。由于推理一直是AI市场中最大、同时也是最具竞争力的领域,业内此前一直希望能够有一套客观的推理性能测试指标。在参与

2019-11-08 19:44:51

拥有ARM而不仅仅是获得ARM的许可,Nvidia可以添加特殊的指令来与其GPU建立更紧密的集成。为了获得最高性能,需要将CPU和GPU集成在一个芯片上,并且由于英特尔正在开发其竞争的Xe系列加速器

2020-09-07 09:49:42

客户在其环境中拥有nVidia Licensing服务器(vSphere Enterprise Plus和Horizon 7)。许可证文件在nVidia企业门户中生成,并且许可证服务器中安装了2

2018-09-20 11:41:44

arm9linux系统平台:最近查ARM9上可以用的轻型WEB服务器 ,有BOA, HTTPD , THTTPD 等等,支持资源比较好的 是BOA ,但这种实现方式需要接入互联网,而且还可能集成

2022-07-22 14:10:59

现在的进展并不快,因为老测试集里面用例数量庞大。目前,老测试集中的用例数量还远远大于新测试集。问题大量的集成测试用例为性能研究提供了方便。笔者通过比较同一测试集在arm64和x86服务器上运行的耗时来

2022-07-12 15:48:13

服务,让传感器和相关的控制设备接入,为此,本期blog将向大家介绍如何使用gevent高性能的并发处理库在draognbaord 410c上来实现一个高性能的TCP服务器。gevent是基于协程

2018-09-25 15:53:03

的示例是在 Arm 上运行 ML 推理的 Linux 应用程序。我们之前已经在MNIST 数据集上训练了一个神经网络 来识别手写数字。使用Arm NN和 Streamline,我们希望了解我们模型

2022-09-27 14:24:27

就不能胜任的话,一台价值几万,甚至几十万的服务器在短时间内就要遭到淘汰,这是任何企业都无法承受的。为了保持可扩展性,通常需要在服务器上具备一定的可扩展空间和冗余件(如磁盘阵列架位、PCI和内存条插槽位

2014-08-02 10:42:26

请问一下,关于 ESP8266 模块在使用 AT 固件的情况下,如何通过域名取得服务器的IP地址和端口号的问题?

2023-03-08 06:36:51

请问一下,关于 ESP8266 模块在使用 AT 固件的情况下,如何通过域名取得服务器的IP地址和端口号的问题?

2023-03-09 06:21:51

Part 1 OpenPPL ARM Server 简介OpenPPL Arm Server 定义• 针对高性能 ARM 架构服务器处理器优化的深度学习推理引擎• 目前支持 FP32 及 FP16

2022-03-31 11:51:33

服务器。 MARS3500系列,就是基于RK3588、RK3588S的高密度ARM阵列服务器,可广泛应用于云手机、云手游、云VR、云电视、云渲染、边缘计算、移动办公、网络舆情监测等领域

2022-07-18 17:54:32

,这在满足个性化需求和增强服务器安全

性上具有优势。

Linux服务器还具有出色的性能和稳定性。相比之下,Windows服务器在性能和稳定性方面稍有不足。特别是在处理高负载和

大数据量的情况下

2024-02-22 15:46:15

、稳定的异构计算云基础设施资源。异构计算GN5规格族实例性能展现相信有了阿里云GPU云服务器的助力,人工智能企业和AI生态一定会取得更多更快的发展。

2017-12-26 11:22:09

`现如今,随着云计算技术的发展,现在很多企业都纷纷选择云服务器,正是因为这种方式可以有效降低企业的成本,而且从性能上来说,也是远远超于传统服务器的,使用也十分的方便。然而,还有一些朋友担心云服务器

2021-03-27 14:31:18

自身的优势,支持企业业务在弹性扩展能力上的高要求,具有高可用性,满足企业对数据进行快速恢复需求。云服务器能够满足企业在电子商务、企业网站、OA系统、企业ERP/CRM管理软件、论坛和SNS等等各种需求

2018-07-31 18:35:28

、内存、系统总线等,和通用的计算机架构类似。由于服务器需要提供高可靠的服务,所以在处理能力、稳定性、可靠性、安全性、可扩展性、可管理性等方面要求较高。服务器和电脑功能都是一样的,也可以将服务器称之为电脑,只是服务器对稳定性与安全性以及处理器数据能力有更高要求。比如我们随时浏览一个网站,发现这个网站

2021-07-16 07:35:04

的是要知道它提供的选项来提高推理性能。作为开发人员,您会寻找可以压缩的每一毫秒,尤其是在需要实现实时推理时。让我们看一下Arm NN中可用的优化选项之一,并通过一些实际示例评估它可能产生

2022-04-11 17:33:06

1.臭皮匠服务器机房分布:国内:福州,湖州,台州,镇江,贵州等地国外:美国,新加坡等国2.臭皮匠服务器优势:我们具有国内技术与服务顶尖的I DC及互联网云安全服务商!我司整合了国内领先的I DC运营

2018-04-21 15:42:54

推理性能与当前服务器级 CPU 相比,VCK190 能够提供超过 100 倍的计算性能。下面是基于 C32B6 DPU 内核的 AI 引擎实现的性能示例,批处理 = 6。有关 VCK190 上各种

2022-11-25 16:29:20

嗨,我想知道,如果可以安装NVIDIA许可证服务器吗?我没有找到任何关于此的明确文件。 setup.exe也没有我能够使用的任何清晰的开关/参数。谢谢,延以上来自于谷歌翻译以下为原文Hi, I

2018-09-18 16:18:10

基于SRAM的方法可加速AI推理

2020-12-30 07:28:28

本人现在在做ARM上构建一个web服务器,就是将网页放在这个服务器上,然后接入internet可以通过PC机上网访问即可。用的是C#编程,实际实现上还是有些模糊,希望有心人能教教俺,最好能给出服务器和客服端的程序做参考说明,先谢过了。。。

2022-10-28 10:55:15

Tengine是什么?如何在RK3399这一 Arm64 平台上搭建 Tengine AI 推理框架,并运行图像识别相关应用?

2022-03-07 07:53:43

Tengine是什么呢?如何在RK3399这一 Arm64平台上搭建Tengine AI推理框架呢?

2022-03-04 12:31:35

使用 PyTorch 对具有非方形图像的 YOLOv4 模型进行了训练。

将 权重转换为 ONNX 文件,然后转换为中间表示 (IR)。

无法确定如何获得更好的推理性能。

2023-08-15 06:58:00

成本比较高,而且不方便工业现场的应用实施,嵌入式系统以及嵌入式小型Web服务器的出现使得Web服务运行在资源、性能有限的嵌入式设备上提供了条件。本文主要介绍嵌入式Web服务器BOA在ARM9嵌入式系统设备板上的移植,并对移植后的BOA服务器进行测试验证。

2019-10-29 06:48:51

的参考。评估TI处理器模型性能的方式有两种:TDA4VM入门套件评估模块(EVM)或TI Edge AI Cloud,后者是一项免费在线服务,可支持远程访问TDA4VM EVM,以评估深度学习推理性能。借助

2022-11-03 06:53:28

1、在Arm服务器上Robox安卓容器方案的构建编译过程和使用方法随着云计算相关产业蓬勃发展,用户对移动设备的弹性需求推动出云手机、云游戏等概念,云手机和云游戏就是将云计算技术运用于网络终端服务

2022-06-17 14:34:24

生成两个 IR文件(相同的 .xml 文件,但不同的 .bin 文件)

具有不同重量的类似模型,以不同的 fps (27fps 和 6fps) 运行

更多样化的权重是否会影响 Myriad X 上的推理性能?

2023-08-15 07:00:25

商业发行之前就已经过时了。算法明天需要对架构、内存/数据进行彻底改革资源和能力。推理的梦幻建筑重新定义重写在计算和交付突破性的人工智能加速和灵活的计算能力超越了服务器级CPU和比GPU/ASIC通用

2020-11-01 09:28:57

(NN)引擎和张量处理架构(Tensor Processing Fabric)技术提供卓越的神经网络推理性能,具有业界领先的能耗效率(TOPS/W)和面积效率(平方毫米/瓦),可扩展的计算能力范围从0.5TOPS( 每秒万亿次运算)到几百TOPS。

2019-09-11 11:52:13

网站权重提高多IP站群服务器,可以大大降低同一IP上的网站数量,如果网站数量在258以下,还可以每个网站分配一个独立IP,从而可以减少网站之间的分权。4、多ip避免封杀网站受影响如果一个ip多个网站

2023-04-18 16:16:20

荷兰服务器的十大优势 1、荷兰机房众多,例如荷兰的阿姆斯特丹机房、莱茵河畔机房等,都是荷兰乃至欧洲最优质的机房。有需要请联系TG:@TW_001 2、荷兰IP众多,一台服务器最高可以添加253个IP

2021-12-16 10:26:55

内存也是内存(RAM),具有一些特有的技术从而有着极高的稳定性和纠错性能。最直观的分辨服务器内存与普通内存的方法就是看条子上的字有没有带ECC模块。◆◆现我司大量在服务器内存条,收购威刚服务器内存条

2021-09-22 19:20:15

、操作系统等,满足不同的需求。综上所述,高防服务器具有很多的优势,能够为客户提供稳定可靠、安全高效、高品质带宽的网络服务。因此,在如今互联网猖獗的环境中,选择一个好的高防服务器,能够在网站运营中起到关键

2023-03-21 12:40:07

27日消息 ARM与联发科技(MediaTek)今日宣布扩大双方长期合作关系,联发科技取得大量市场领先的高性能ARM知识产权(IP)授权,包括可用于智能手机、智能电视与蓝光播放器的ARMMali系列

2012-02-28 09:11:01 737

737 针对CLINK算法在路由改变时拥塞链路推理性能下降的问题,建立一种变结构离散动态贝叶斯网模型,通过引入马尔可夫性及时齐性假设简化该模型,并基于简化模型提出一种IP网络拥塞链路推理算法(VSDDB

2018-01-16 18:46:26 0

0 Azure Machine Learning SDK 相集成以供预览。客户可以使用 Azure 大规模部署的英特尔 FPGA(现场可编程逻辑门阵列)技术,为其模型提供行业领先的人工智能 (AI) 推理性能。 “作为一家整体技术提供商,我们通过与 Microsoft 密切合作为人工智能提供支持。

2018-05-20 00:10:00 2865

2865 TaiShan系列服务器主要面向大数据、分布式存储和ARM原生应用等场景,发挥ARM架构在多核、高能效等方面的优势,为企业构建高性能、低功耗的新计算平台;例如大数据场景,实现了多核高并发和资源调度调优,计算性能提升20%。基于TaiShan服务器,华为云也将提供弹性云服务、裸金属服务和云手机服务。

2019-01-09 09:39:05 10813

10813 MLPerf Inference 0.5是业内首个独立AI推理基准套件,其测试结果证明了NVIDIA Turing数据中心GPU以及 NVIDIA Xavier 边缘计算芯片系统的性能。

2019-11-29 14:45:02 2696

2696 NVIDIA和多家全球领先的服务器制造商于今日发布多款内置NVIDIA A100的系统。这些系统具有多种不同的设计和配置,可应对AI、数据科学和科学计算领域最复杂的挑战。

2020-06-24 16:04:33 2585

2585 结合NVIDIA 领先的人工智能技术与 Arm 庞大的计算生态系统,让创新成果惠及所有客户 NVIDIA 将建立世界先进的 AI 研究和教育中心来扩大Arm在英国剑桥的研发业务,并打造采用 Arm

2020-09-21 13:44:17 1347

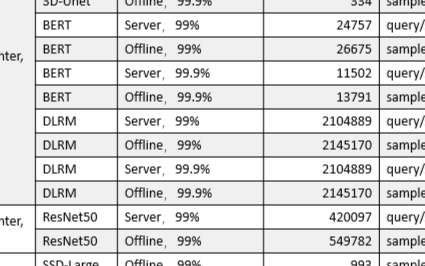

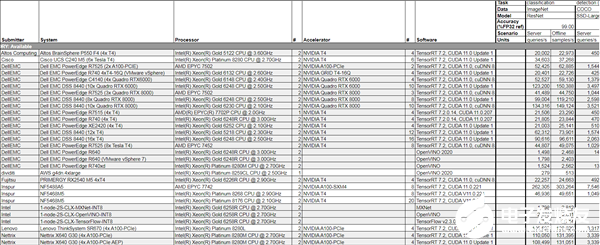

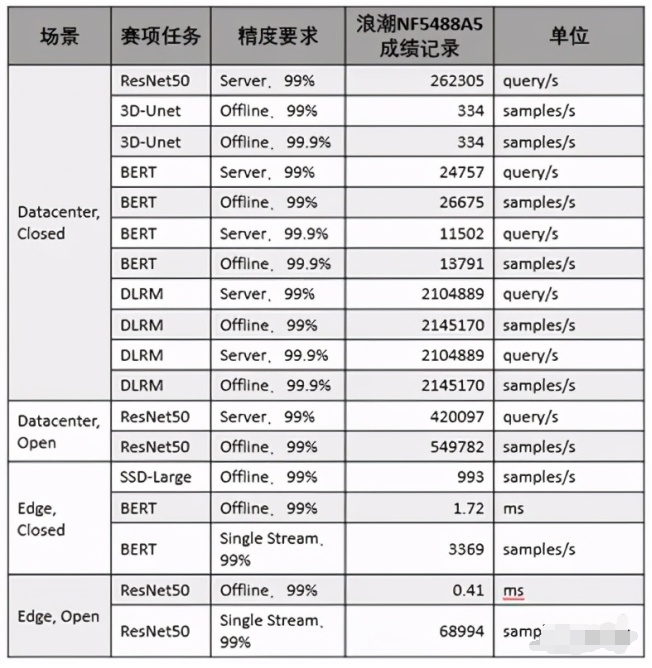

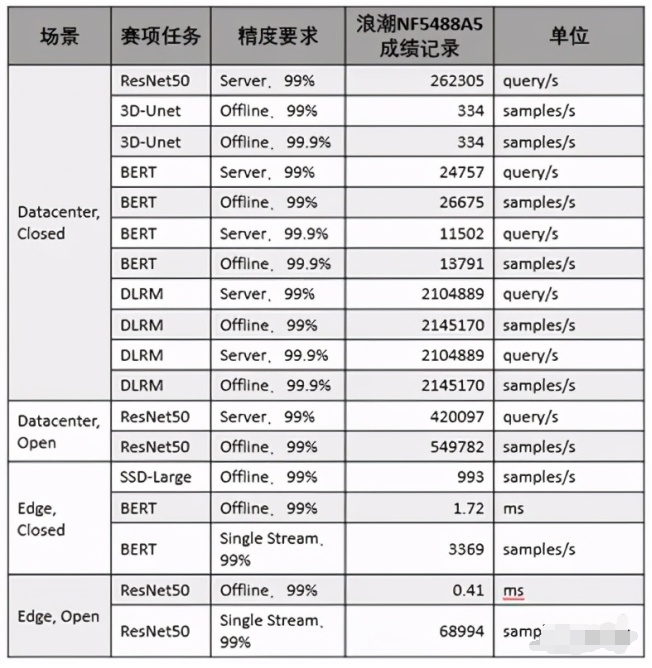

1347 美国东部时间10月21日,全球备受瞩目的权威AI基准测试MLPerf公布今年的推理测试榜单,浪潮AI服务器NF5488A5一举创造18项性能纪录,在数据中心AI推理性能上遥遥领先其他厂商产品

2020-10-23 16:59:44 1615

1615

的237倍。 MLPerf Inference V0.7部分结果截图 最新的AI推理测试结果意味着,NVIDIA未来可能在AI推理和训练市场都占据领导地位,给云端AI推理市场拥有优势的Intel带来更大压力的

2020-10-23 17:40:02 3929

3929

弗洛伊德说:“英伟达在竞争激烈的竞争者中表现出色。” 与(Nvidia)V100(GPU)相比,他们的A100效果惊人,证明了其增强的Tensor核心架构的价值。我赞扬MLPerf添加了新的基准,这些基准越来越代表快速增长的推理机会,例如推荐引擎。

2020-10-24 09:17:15 1995

1995 美国东部时间10月21日,全球倍受瞩目的权威AI基准测试MLPerf公布今年的推理测试榜单,浪潮AI服务器NF5488A5一举创造18项性能记录,在数据中心AI推理性能上遥遥领先其他厂商产品。

2020-10-26 16:30:44 1709

1709

近日,在GTC China元脑生态技术论坛上,中科极限元、趋动科技、睿沿科技等元脑生态伙伴分享了多个场景下浪潮AI服务器NF5488A5的实测数据,结果表明浪潮NF5488A5大幅提升了智能语音、图像识别等AI模型的训练和推理性能,促进了产业AI解决方案的开发与应用。

2020-12-24 15:25:01 2123

2123

一个支持边缘实时推理的姿态估计模型,其推理性能比OpenPose模型快9倍。

2021-06-25 11:55:52 1450

1450 ,其中的模型数量达数千个,日均调用服务达到千亿级别。无量推荐系统,在模型训练和推理都能够进行海量Embedding和DNN模型的GPU计算,是目前业界领先的体系结构设计。 传统推荐系统面临挑战 传统推荐系统具有以下特点: 训练是基于参数

2021-08-23 17:09:03 4486

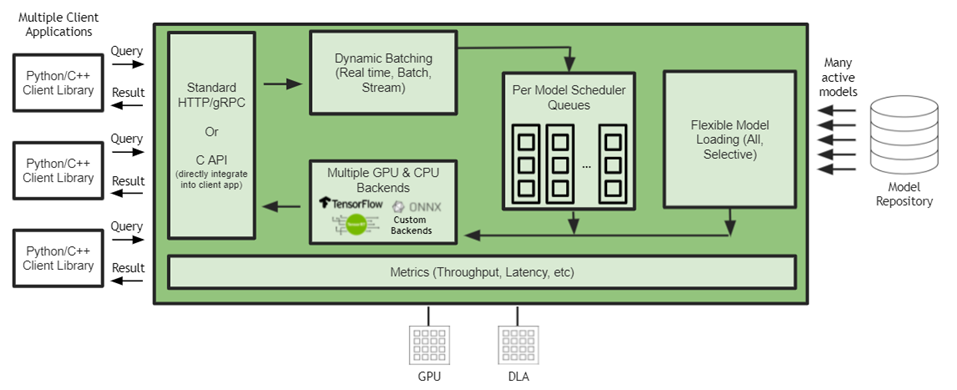

4486 Capital One、Microsoft、Samsung Medison、Siemens Energy、Snap等25000多家客户都在使用该平台。 这些更新包括开源NVIDIA Triton推理服务器

2021-11-12 14:42:53 1684

1684 西门子能源公司正在发挥 NVIDIA Triton 推理服务器的强大力量,利用 AI 协助解决全球发电厂在预测性服务管理方面的担忧。

2021-11-16 16:25:31 3490

3490 Microsoft Teams借助AI生成的实时字幕和转录功能,帮助全球学生和职场人士顺利进行在线会议。用于训练的NVIDIA AI计算技术和用于推理语音识别模型的NVIDIA Triton推理服务器进一步提升了这两个功能。

2022-01-04 14:20:11 1407

1407 Microsoft Teams借助AI生成的实时字幕和转录功能,帮助全球学生和职场人士顺利进行在线会议。用于训练的NVIDIA AI计算技术和用于推理语音识别模型的NVIDIA Triton推理服务器进一步提升了这两个功能。

2022-01-04 17:45:12 1472

1472 能力。 一、GPU服务器处理性能和用例: 1、GPU 用例 虽然投资 GPU 服务器的原因过于广泛,无法在一篇文章中涵盖,但我们已经概述了我们在过去几年中看到的最喜欢的用例。 2、3D处理 GPU 服务器非常适合 2D 和 3D 计算以及渲染 3D 图形和 GPU 技术,以至于

2022-02-22 16:44:04 1434

1434 NVIDIA Grace CPU是首款面向AI基础设施和高性能计算的基于Arm Neoverse的数据中心专属CPU,是当今领先服务器芯片内存带宽和能效的两倍。

2022-03-30 14:11:31 1489

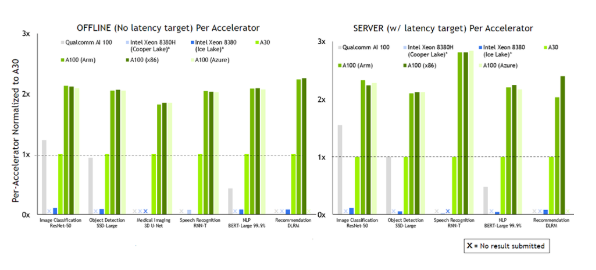

1489 在首次参加行业 MLPerf 基准测试时,基于 NVIDIA Ampere 架构的低功耗系统级芯片 NVIDIA Orin 就创造了新的AI推理性能纪录,并在边缘提升每个加速器的性能。

2022-04-08 10:14:44 4200

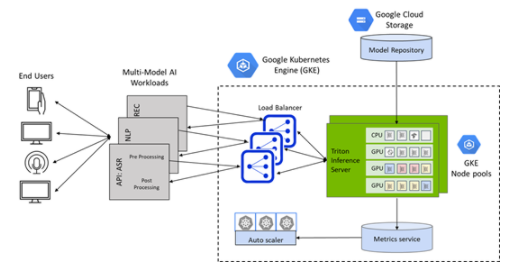

4200

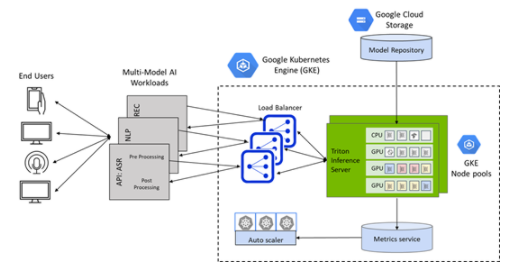

GKE 的 Triton 推理服务器应用程序是一个 helm chart 部署程序,可自动安装和配置 Triton ,以便在具有 NVIDIA GPU 节点池的 GKE 集群上使用,包括

2022-04-08 16:43:03 1855

1855

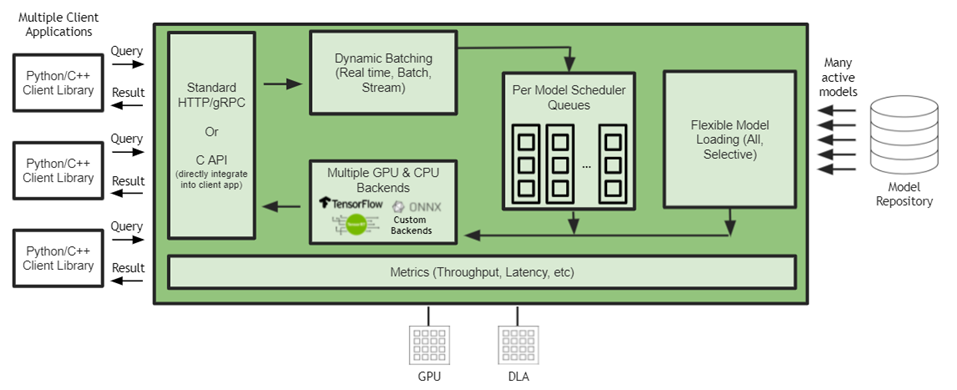

NVIDIA Triton 有助于在每个数据中心、云和嵌入式设备中实现标准化的可扩展生产 AI 。它支持多个框架,在 GPU 和 DLA 等多个计算引擎上运行模型,处理不同类型的推理查询。通过与 NVIDIA JetPack 的集成, NVIDIA Triton 可用于嵌入式应用。

2022-04-18 15:40:02 2306

2306

网易互娱 AI Lab 的研发人员,基于 Wenet 语音识别工具进行优化和创新,利用 NVIDIA Triton 推理服务器的 GPU Batch Inference 机制加速了语音识别的速度,并且降低了成本。

2022-05-13 10:40:19 1481

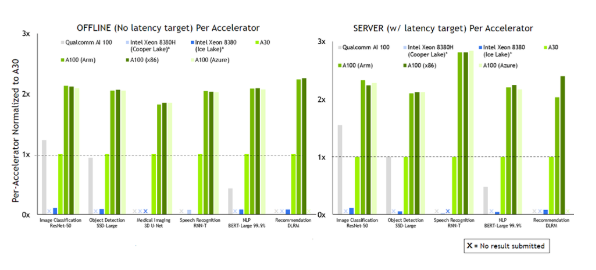

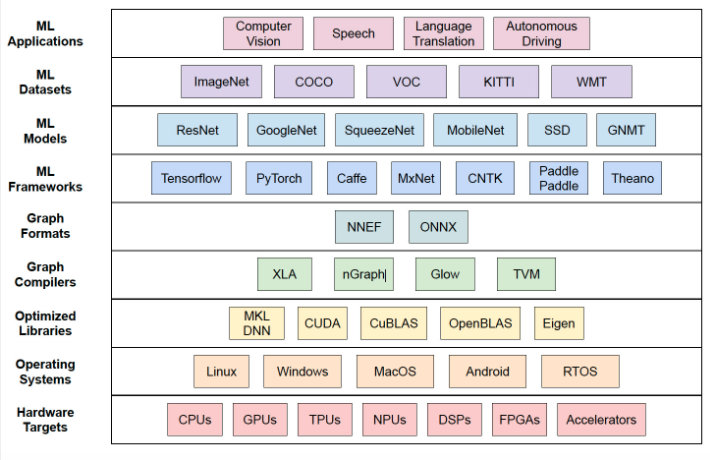

1481 最新的 AI 推理基准显然具有重要意义,因为它是目前可用的最接近真实世界 AI 推理性能的衡量标准。但随着它的成熟和吸引更多的提交,它也将成为成功部署技术堆栈的晴雨表和新实施的试验场。

2022-07-08 15:37:55 1246

1246

腾讯云 TI 平台 TI-ONE 利用 NVIDIA Triton 推理服务器构造高性能推理服务部署平台,使用户能够非常便捷地部署包括 TNN 模型在内的多种深度学习框架下获得的 AI 模型,并且显著提升推理服务的吞吐、提升 GPU 利用率。

2022-09-05 15:33:01 1419

1419 蚂蚁链 AIoT 团队与 NVIDIA 合作,将量化感知训练(QAT)技术应用于深度学习模型性能优化中,并通过 NVIDIA TensorRT 高性能推理 SDK 进行高效率部署, 通过 INT8 推理, 吞吐量提升了 3 倍, 助力蚂蚁链版权 AI 平台中的模型推理服务大幅降本增效。

2022-09-09 09:53:52 872

872 推理识别是人工智能最重要的落地应用,其他与深度学习相关的数据收集、标注、模型训练等工作,都是为了得到更好的最终推理性能与效果。

2022-10-26 09:43:57 1370

1370 、NVIDIA 的技术专家将带来 AI Infra 、 推理引擎 相关的专题分享,包括目前各企业面临的模型推理挑战、Triton 的应用及落地的具体方案等,现身说法,干货十足。此外,还有来自

2023-02-15 16:10:05 207

207 AI推理性能对比 / Ampere 从性能对比上,我们可以看出AmpereOne在AI推理负载上的领先,比如在生成式AI和推荐算法上,AmpereOne的单机架性能是AMD EYPC 9654 Genoa的两倍或以上,但两者却有着近乎相同的系统功耗,AmpereOne的优势在此展现得一览无余。

2023-06-13 15:03:51 789

789

AI 服务器确实是整个服务器市场的一部分,但它们是专门为基于云的 AI 模型训练或推理而设计的。在规格方面,广义的AI服务器是指搭载AI芯片(如前面提到的GPU、FPGA、ASIC)的服务器,而狭义的定义则包括至少搭载一块GPU的服务器。

2023-06-21 12:40:02 1208

1208 使用集成模型在 NVIDIA Triton 推理服务器上为 ML 模型管道提供服务

2023-07-05 16:30:34 1082

1082

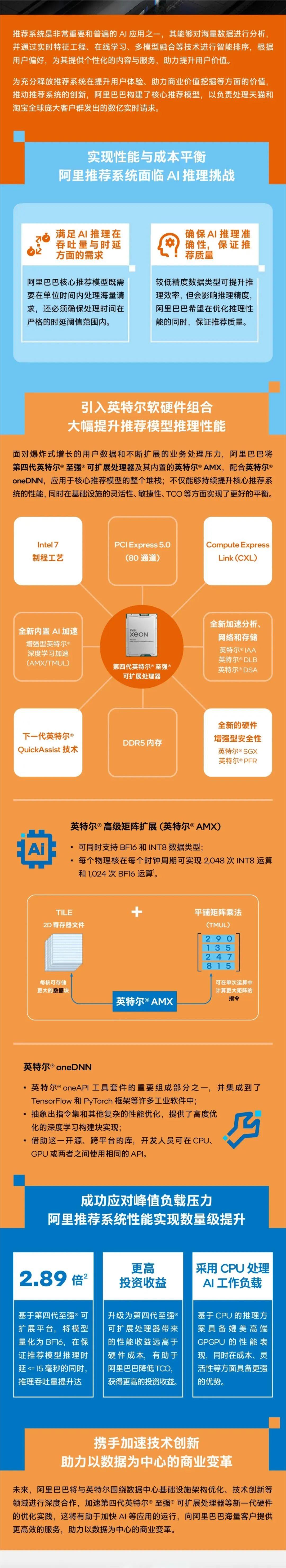

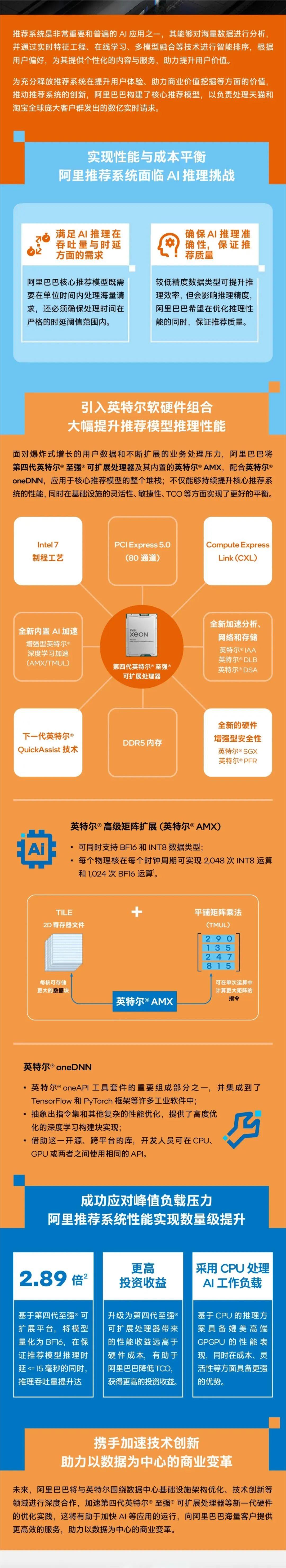

达沃斯论坛|英特尔王锐:AI驱动工业元宇宙,释放数实融合无穷潜力 英特尔研究院发布全新AI扩散模型,可根据文本提示生成360度全景图 英特尔内部代工模式的最新进展 原文标题:英特尔® AMX 加速AI推理性能,助阿里电商推荐系统成功应对峰值负载

2023-07-08 14:15:03 294

294

科技赋能千行百业 人民网携手英特尔启动“数智加速度”计划 WAIC 2023:英特尔以技术之力推动边缘人工智能发展,打造数字化未来“芯”时代 英特尔 AMX 加速AI推理性能,助阿里电商推荐系统成功应对峰值负载压力 原文标题:英特尔® AMX 助力百度ERNIE-T

2023-07-14 20:10:05 245

245

with NVIDIA 拉斯维加斯 — VMware Explore — 太平洋时间 2023 年 8 月 22 日 — NVIDIA 宣布,全球领先的系统制造商将推出 AI 就绪型服务器,其支持同发布的 VMware

2023-08-23 19:10:09 350

350 英特尔产品在全新MLCommons AI推理性能测试中尽显优势 今日,MLCommons公布针对 60 亿参数大语言模型及计算机视觉与自然语言处理模型GPT-J的 MLPerf推理v3.1 性能基准

2023-09-12 17:54:32 200

200

超级芯片 首次亮相 MLPerf 行业基准测试,其运行了所有数据中心推理测试,进一步扩大了 NVIDIA H100 Tensor Core GPU 的领先优势。 总体测试结果表明,NVIDIA AI

2023-09-12 20:40:04 249

249 Hopper超级芯片首次亮相 MLPerf 行业基准测试,其运行了所有数据中心推理测试,进一步扩大了NVIDIA H100 Tensor Core GPU的领先优势。 总体测试结果表明,NVIDIA AI

2023-09-13 09:45:40 139

139

加利福尼亚州圣克拉拉——Nvidia通过一个名为TensorRT LLM的新开源软件库,将其H100、A100和L4 GPU的大型语言模型(LLM)推理性能提高了一倍。 正如对相同硬件一轮又一轮改进

2023-10-23 16:10:19 284

284 ,使用 NVIDIA Triton TM 推理服务器进行端到端部署 LLM Serving,以及金融行业的 AI、NLP/LLM 应用场景、客户案例。 通过本次活动,您将了解基于上述产品的 LLM

2023-10-26 09:05:02 174

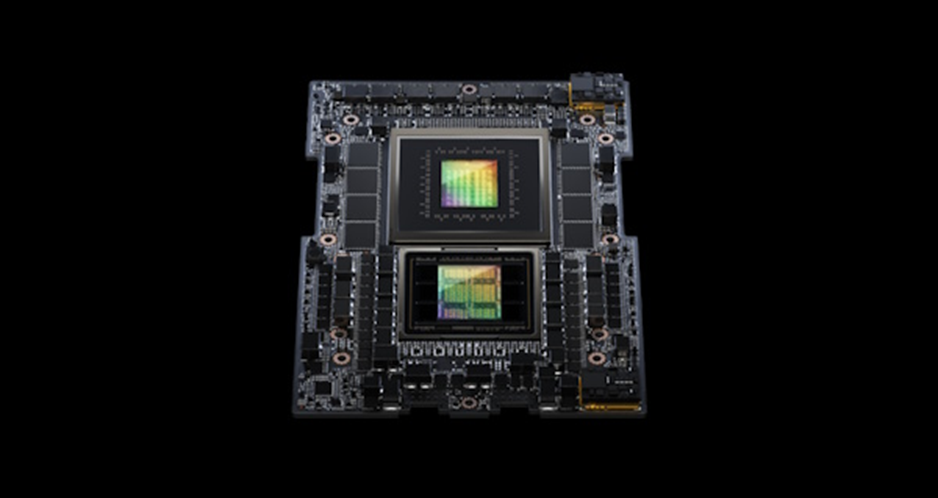

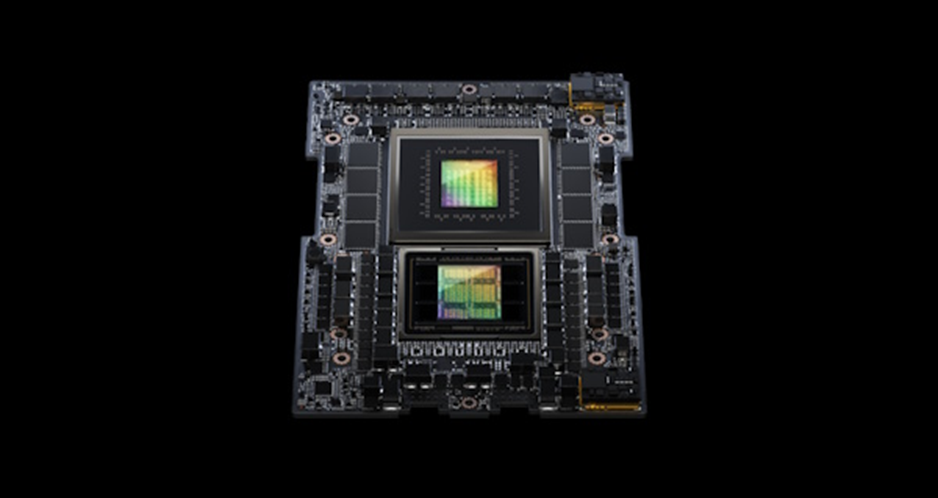

174 上以交互速率运行的 Llama-2-70B 模型。 图 1. 领先的生成式 AI 模型在 Jetson AGX Orin 上的推理性能 如要在 Jetson 上快速测试最新的模型和应用,请使用 Jetson 生成式 AI 实验室提供的教程和资源。

2023-11-07 21:25:01 398

398

Tensor Core GPU 和领先的显存配置,可处理生成式 AI 与高性能计算工作负载的海量数据。 NVIDIA H200 是首款采用 HBM3e 的 GPU,其运行更快、更大的显存容量将进一步加速生成式 AI 与大语言模型,同时

2023-11-14 14:30:01 85

85

作者: 英特尔公司 沈海豪、罗屿、孟恒宇、董波、林俊 编者按: 只需不到9行代码, 就能在CPU上实现出色的LLM推理性能。 英特尔 Extension for Transformer 创新

2023-12-01 20:40:03 552

552

那么,什么是Torch TensorRT呢?Torch是我们大家聚在一起的原因,它是一个端到端的机器学习框架。而TensorRT则是NVIDIA的高性能深度学习推理软件工具包。Torch TensorRT就是这两者的结合。

2024-01-09 16:41:51 286

286

这家云计算巨头的计算机视觉和数据科学服务使用 NVIDIA Triton 推理服务器来加速 AI 预测。

2024-02-29 14:04:40 162

162

电子发烧友App

电子发烧友App

评论