对于智能车辆来说,多传感器融合对于高精度和鲁棒性的感知交通环境至关重要。在这篇论文中,我们提出了两种有效的方法,即时空证据生成和独立视觉通道,以改善多传感器跟踪水平对车辆环境感知的影响。时空证据包括即时证据、跟踪证据和跟踪匹配证据,以改进存在融合。

独立视觉通道利用视觉处理在物体识别上的特殊优势来改进分类融合。利用从实际交通环境中采集的多传感器数据集对所提出的方法进行了评估。实验结果表明,该方法在检测精度和分类精度方面均可显著提高多传感器轨道级融合。

Ⅰ.介绍

交通环境中的物体感知的鲁棒性对于自动驾驶和高级驾驶辅助系统( ADAS )都具有重要意义。物体感知可以通过不同类型的传感器来实现,例如激光雷达、雷达和摄相机。激光雷达和雷达是有源传感器,可以测量物体的精确距离,但物体分类的能力较差。而摄像机在物体识别方面表现出优异的性能,但是测量物体距离的能力较差。雷达对测量物体的速度更敏感,激光雷达更适合于感知物体的形状。总之,这些传感器各有优缺点[ 1 ]。因此,融合不同的传感器有望实现物体感知的高精度和鲁棒性。

传感器融合系统已经被研究了几十年。通常,传感器融合方法可分为三类:低级、特征级和高级融合方法。

低级融合架构不需要在传感器级对原始数据进行预处理。尽管低级融合[ 2 ]对物体有很强的描述能力,但它需要很高的数据带宽,并且在实践中实施起来可能很复杂。

特征级融合[ 3 ]试图在进行数据融合之前,通过预处理步骤从原始数据中提取某些特征。特征级融合可以降低复杂性,但在实践中仍然难以实现。

在高级融合[ 4 ]中,每个传感器独立地执行跟踪算法并生成目标列表。高级融合可以产生最佳的感知性能,因为它具有模块化、实用性和可扩展性。

因此,在本文中,我们将重点放在高级融合上,也称为轨道级融合。轨道级融合的一个潜在缺点是它对物体的描述能力较差。因此,在轨道级融合设计中,我们应该更加关注物体的完整描述,如分类、形状等。

许多轨道级融合方法[ 5 ]–[ 7 ]已经被提出,并对目标感知做出了巨大贡献。在跟踪目标时,我们主要关注三种信息:1 )目标的存在概率;2 )目标状态的准确性,包括位置、速度和方向,反映在目标的全局轨迹上;3 )其他描述信息的完整性,如分类、形状等。

因此,轨道级融合主要包括存在融合、轨道间融合和分类融合。参考文献[ 5 ]和[ 6 ]使用基于证据理论(DST)的存在融合方法来估计物体的存在概率。然而,它们的存在证据只考虑瞬时的空间证据,而忽略了时间证据,因此会产生相对高的误报率和误报率,特别是在高度动态的交通环境下。参考[ 5 ]和[ 7 ]提出了使用信息矩阵融合( IMF )来估计物体状态的轨道间融合方法。然而,它们像其他主动传感器一样融合图像对象,同时忽略图像对象的不准确位置,这导致相对高的假阴性率、检测的假阳性率和相对低的正确识别率。

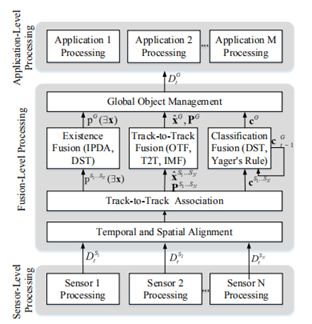

图1 :最新轨道级融合的框架

为了解决上述两个问题,我们提出了两种方法,即时空证据生成( STEG )和独立视觉通道( IVC ),以改进多传感器轨道级融合。STEG方法提高了存在估计的准确性,从而提高了轨道级融合的检测精度。IVC方法不仅提高了轨道融合的检测率,而且提高了轨道融合的正确分类率。利用从实际交通环境中收集的多传感器数据集对所提出的方法进行了评估。实验结果清楚地证明了所提方法在轨道级融合中的有效性。与没有STIG的方法相比,所提出的STIG方法在相似误报率的情况下将目标检测的误报率降低了0.06,并且在相似误报率的情况下与没有STIG的方法相比将误报率降低了0.08。同时,所提出的IVC方法将目标检测的假阴性率降低了0.01,并将目标识别的正确分类率提高了0.19。

Ⅱ.轨道级融合的背景

为了正确检测室外环境中的目标,并且大多数情况下不会因为进入和离开视场而丢失物体信息,多传感器数据应该在轨道级融合。如图1所示,轨道级融合的框架包括传感器级处理、融合级处理和应用级处理。在传感器级处理中,我们独立地从每个传感器获得传感器局部对象列表:

其中t是时间戳,Si表示传感器i,Oj是对检测对象的描述,包括状态xˇ、状态协方差Pˇ、存在概率p和分类c。在融合级处理中,来自不同传感器的对象列表首先在空间和时间上与公共坐标系对齐。跟踪到跟踪关联后,传感器级对象会列出DtS1...SN通过存在融合、轨道融合和分类融合融合在一起,形成全局目标列表DtG。在应用程序级处理中,全局对象列表DtG与特定应用程序的其他数据源相结合。

存在融合是从独立的传感器级估计中融合目标存在概率,生成全局目标存在概率估计。这对提高目标跟踪的鲁棒性非常重要。对于单传感器目标跟踪,存在概率主要通过归一化创新平方( NIS )来估计。最近还提出了几种更先进的方法。例如,[ 8 ]提出了一种利用立体视觉和跟踪过程中的几个线索来估计物体存在概率的方法。对于多传感器目标跟踪,在综合概率数据关联( IPDA )框架中开发了目标存在概率估计,作为检测目标的质量度量[ 9 ]。参考文献[ 6 ]提出了一种基于DST的目标存在概率估计的融合方法,其中组合了由每个传感器估计的目标存在。

轨道间融合来自独立传感器级估计的目标状态及其协方差,以生成全局目标状态估计。参考[ 10 ]提出了目标轨道融合( OTF )方法,其中传感器级轨迹被视为对全局目标轨迹的测量,忽略了相关性和信息冗余。参考文献[ 11 ]介绍了轨道到轨道融合( T2T )方法,该方法通过近似技术计算互相关度,这种方法存在缺陷。IMF在用于将多传感器各自的目标轨迹融合成全局轨迹,并显示出出色的性能。基于IMF的方法在[ 7 ]中提出,该方法使用IMF来处理速度相关性,实现了集中式架构的可比性能。[ 12 ]对现有的用于物体状态估计的轨道间融合方法进行了精度比较。它表明IMF对过程噪声最鲁棒,在过程模型偏差期间最准确和一致。

分类融合旨在改进全局对象的分类估计。大多数分类融合方法基于证据理论,这是一种基于不完全和不确定信息的决策工具。对于全局对象分类融合,找到合适的证据至关重要。参考[ 13 ]–[ 15 ]使用基于DST的方法来估计全局目标轨迹的分类。[ 13 ]提议的基于DST的融合方法依赖于两个主要证据:瞬时融合证据,从当前每个物体的单个传感器提供的证据组合中获得;以及动态融合证据,其将来自先前结果的证据与瞬时融合结果相结合。在[ 14 ]中,作者提出了一种基于证据理论的目标栅格地图融合,以决定是否占据栅格。提出了一种基于DST的分类方法[ 15 ]来融合全局轨迹的瞬时分类结果和先前的分类结果。参考[ 16 ]和[ 17 ]使用Yager规则组合来自不同传感器的物体分类证据,进一步用于关联来自不同传感器的物体。

III.轨道级融合

A.总体框架

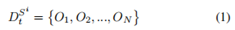

图2示出了我们所提出的轨道级融合的框架。整体框架非常类似于最先进的轨道级融合框架。特别是,对于时间和空间对齐,我们采用了我们先前工作[ 8 ]中介绍的相同方法,将独立的传感器级对象列表同步并校准到公共坐标系。然后,我们使用匈牙利算法来关联来自多个传感器的时间和空间对齐的对象列表。我们将DST用于存在融合和分类融合,以及IMF用于轨道到轨道融合。主要原因是DST和IMF分别是最有效的方法。

图2 :轨道级融合框架

本文提出的框架和最新框架之间的主要区别可以描述如下。

我们提出了一种基于DST的存在融合时空证据生成方法。我们同时考虑空间瞬时证据、时间跟踪证据和跟踪匹配证据,以改进存在融合。

我们使用独立的视觉通道将图像对象信息融合到全局轨道中。IVC的使用不仅可以改进分类融合,还可以避免对航迹融合的负面影响。

B.时空证据生成

1 )即时证据生成:当一个物体出现在感知范围内时,我们需要证据来即时支持存在融合。单个传感器存在估计的鲁棒性实际上非常低。因此,直接使用单传感器存在估计[ 6 ]进行存在融合是不合适的。为了提高目标检测的鲁棒性,我们使用瞬时测量的匹配信息作为证据来支持目标存在估计。我们使用匈牙利算法从不同传感器获取不同目标列表的瞬时匹配信息,其中我们计算不同列表中目标之间的欧氏距离作为权重矩阵。

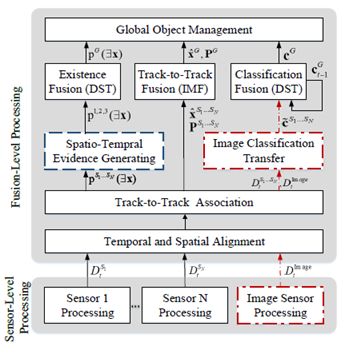

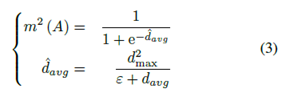

我们将临界距离定义为d1max,并将两个独立传感器的距离定义为di,j。如果di,j小于d1max且对象i与对象j匹配,则定义瞬时证据质量,利用Sigmod函数将di,j映射到质量集[a,b]。Sigmod函数定义为

其中ε是接近于零的正常量。

2 )跟踪证据生成:当一个物体在一段时间内只被一个传感器检测到时,我们无法从多个传感器获得证据。由于单个传感器对目标的瞬时测量不稳定,我们将目标跟踪历史作为存在融合的证据。

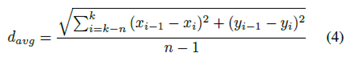

我们计算一段时间内同一轨道上当前帧和前一帧的对象之间的平均欧氏距离,以获得支持存在估计的质量。大量证据被定义为

其中ε是如B1小节中提到的常数,d2max是与物体速度相关联的临界距离。davg由轨道的长度和平滑度估计,定义为

其中k是当前时间戳,n - 1是轨道的选定长度。

3 )跟踪匹配证据生成:如果一个物体在一段时间内被几个传感器同时观察到,这意味着这个物体几乎肯定存在。这是物体存在融合的有力证据。

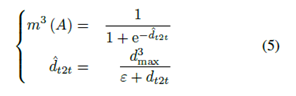

在本文中,我们计算来自不同传感器的两个目标轨道的平均欧几里德距离,以获得支持存在估计的质量。大量有力的证据被定义为

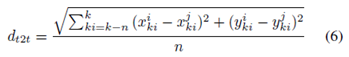

其中ε是接近零的正常数,dt2t是两条轨道之间的平均距离。Dt2t定义为

其中ki是时间戳,而i,j代表不同的传感器,n是轨道长度。

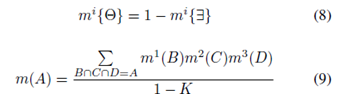

4 )基于DST的存在融合:对于目标存在概率融合,我们获得了上述三种证据,即瞬时证据、跟踪证据和跟踪匹配证据。

存在概率识别框架定义为

其中彐代表存在。实际上,我们计算质量m(彐 )和质量m(θ),其中θ是未知的命题。在[ 6 ]中,如果一个物体在传感器的范围内,而传感器未能检测到该物体,它们定义了m(彐 )的质量。由于遮挡问题和传感器的不可靠性,这是不合适的。因此,假设A代表存在或未知的命题,我们有三个质量值来支持如上计算的命题A、m1(A )、m2(A )和m3(A )。我们使用[ 6 ]中提出的组合和判别规则计算融合存在概率,该规则定义为

其中K定义为

C.独立视觉通道

在所有传感器中,摄像机传感器的识别能力是最出色的。因此,必须融合图像信息,以实现全面的物体感知。然而,由图像传感器检测到的物体的真实位置并不像其他有源传感器那样精确,因为摄像机校准参数不能适应室外交通环境的所有条件。例如,安装在车辆上的摄像机可能会随着车辆在不平的道路上行驶而晃动。如果IMF方法使用与其他传感器相同的图像对象列表,将导致相对较高的对象检测假阴性和假阳性率,从而导致相对较低的对象识别正确分类率。参考[ 19 ]指出了图像对象的不准确位置,因此提出了一种融合图像信息的方法。然而,该方法要求其他传感器必须获得几何信息以匹配图像对象的形状,这对于没有感知形状信息能力的传感器来说通常是不可用的。

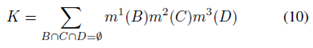

为了解决上述问题,我们提出了一种独立的视觉通道方法来更恰当地融合图像对象信息。提出的独立视觉通道独立处理图像对象列表,避免了对轨道融合的负面影响。此外,独立的视觉通道将图像信息传递给有源传感器的目标,因此也可以改进轨道级融合的分类估计。我们首先使用A3小节中提到的轨道匹配算法将图像对象的轨道与其他传感器的轨道进行匹配。当当前时间戳或先前时间戳的dt2t小于d3max时,我们将图像对象信息(如分类)传输到另一个活动传感器的对象。之后,我们首先使用DST作为等式( 12 ),将转移的分类c~i和自含分类cSj融合为c~Sj。然后,我们使用DST作为等式( 13 ),将当前分类和先前分类进行融合。

Ⅳ.实验结果

A.实验装置

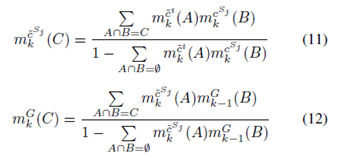

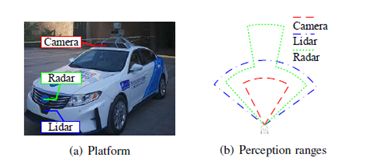

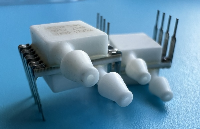

所有物体感知实验都在西安交通大学开发的“发现号”自动驾驶车辆研究平台上进行。该平台旨在满足一般自主驾驶研究的要求,同时也在努力应对环境感知的挑战。“发现”在2017年赢得了中国智能车辆未来挑战( IVFC )。如图3 ( a )所示,“发现号”安装有一台德尔菲ESR MMW雷达、一台单目点灰色摄像机和一台ibeo LUX - 8L。图3 ( b )示出了三个传感器的具体感知范围。表I列出了这三种传感器的类型、视场( FOV )、范围和更新速率。

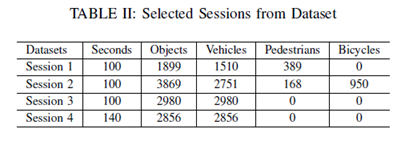

实验中使用的数据集是由安装在西安市城市道路“发现号”上的多个传感器收集的。摄像机和雷达的捕获速率为10fps,激光雷达的捕获速率为6.25fps。我们已经同时捕获了45287帧的同步数据集,包括相机、激光雷达和雷达数据。从数据集中,我们选择4个会话来测试建议的方法,如表所示

图3 : XJTU自动驾驶车辆研究平台“发现号”的传感器配置

我们已经预处理了4个选定的会话。MMW雷达目标直接从雷达传感器读取,图像目标由单镜头多盒检测器( SSD ) [ 20 ]模型检测,激光雷达数据由基于密度的带噪声应用空间聚类( DBSCAN ) [ 21 ]处理。雷达和激光雷达的目标分别被卡尔曼滤波器跟踪。

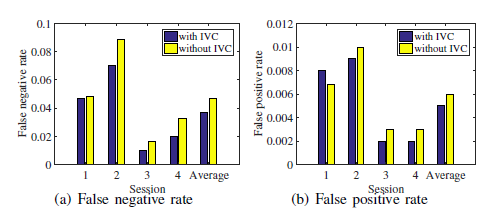

B.时空证据生成的结果

与文献[6]中提出的时空证据生成方法相比,本文提出的时空证据生成方法从目标检测的假阴性率和假阳性率两方面对该方法进行了评价。如果存在一个对象,则将其与全局轨道相融合。因此,为了评估存在性融合的性能,我们分别计算了目标检测的全局假阴性率和假阳性率。

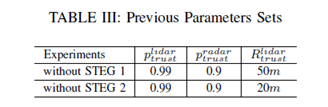

在我们的工作中,我们为Steg方法选择了一组参数,d1max=d2max=d3max=2.2m;ε=0:0001。该方法可以通过改变目标检测的参数来调整目标检测的假阴性率和假阳性率。因此,我们选择了两组参数,即不带STEG 1的参数,与STEG方法相似的假阳性率参数和不带步骤2的参数,与STEG方法的假阴性率相似。表三列出了前面方法的两组参数。雷达信任度是激光雷达传感器的感知范围。在感知范围内,如果雷达传感器检测到目标,而激光雷达传感器出现故障,则导致目标的不存在。

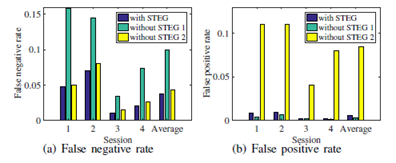

如图4所示,在类似假阳性率的情况下,所提出的STEP方法比不带STG的方法降低了目标检测的假阴性率0.06;在类似假阴性率的情况下,与没有STIG的方法相比,该方法降低了0.08%的假阳性率。

图4:STEG检测精度比较

C.独立视觉通道的结果

图5 :对象ID变化比较的示例

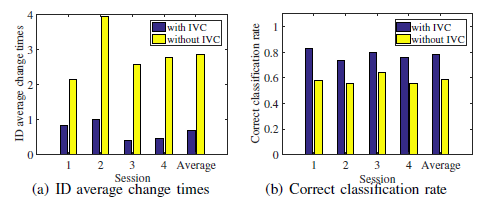

较高的误检率会导致全局目标轨迹的识别号(ID)发生较大的变化。IVC方法可以减少假阴性率和ID变化次数。图5(A)示出交通场景,其中正面汽车(标记为红色边框)正在移动。图5(B)分别示出了该方法与IVC提供的汽车轨道的ID变化比较,以及不使用IVC的方法,其中每种颜色代表一个ID。所提出的IVC方法提供的轨迹ID在20秒内不发生变化,但在没有IVC的情况下,该方法提供的ID变化了两次。图6示出了目标检测的假阴性率和假阳性率的比较。比较结果表明,与不含IVC的方法相比,采用IVC的方法可使假阴性率降低0.01。虽然对目标检测的假阴性率的提高相对较小,但可以减少ID的平均变化次数,从而有效地提高了分类融合的效果。

本文采用基于DST的分类融合方法,利用现有的传感器证据和以往的全局分类证据来确定目标的分类。因此,当对象ID发生变化时,会丢失以前的分类证据,从而导致分类正确率较低。图7示出了对象id的平均变化时间和正确的分类率。结果表明,该方法的平均变化次数为0.67,比无IVC的方法低3倍以上。该方法的正确分类率为0.78,比不含IVC的方法高0.19。

图6:IVC检测精度比较

图7 : IVC分类精度比较

V.结论

在这篇论文中,我们提出了两种方法来改进用于目标感知的轨道级融合。首先,我们提出了一种时空证据生成方法,用于目标存在概率融合,以降低误报率和误报率。其次,我们提出了一种独立的视觉通道方法来改进跟踪-跟踪融合和分类融合。最后,通过从实际交通环境中采集的多传感器数据集对所提出的方法进行了评估。实验结果表明,该方法在检测精度和分类精度方面均可显著提高多传感器轨道级融合。在未来的工作中,我们将考虑使用摄像机对道路场景的理解来帮助物体融合感知。

-

传感器

+关注

关注

2522文章

47978浏览量

739672 -

智能

+关注

关注

8文章

1680浏览量

116931 -

轨道

+关注

关注

0文章

37浏览量

10993

原文标题:利用时空证据和独立视觉通道改善车辆环境感知的多传感器融合

文章出处:【微信号:IV_Technology,微信公众号:智车科技】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

Spring Boot和飞腾派融合构建的农业物联网系统-改进自适应加权融合算法

激光雷达与视觉感知的优劣对比

无线传感器网络数据融合技术研究与仿真

感知进入3.0时代,新一代传感器发展有力

智驾系统感知层面最常见的几种传感器

智驾系统感知层面常见的几种传感器

深度学习传感器融合技术在自动驾驶汽车感知与定位中的应用研究

传感器融合与自动驾驶的关键技术

利用时空证据和独立视觉通道改善车辆环境感知的多传感器融合

利用时空证据和独立视觉通道改善车辆环境感知的多传感器融合

评论