来自:复旦DISC

引言

本次分享我们将介绍三篇来自ACL2021的跨视觉语言模态的论文。这三篇文章分别介绍了如何在图像描述任务中生成契合用户意图的图像描述、端对端的视觉语言预训练模型和如何生成包含更多细节的图像描述。

文章概览

Control Image Captioning Spatially and Temporally

论文地址:https://aclanthology.org/2021.acl-long.157.pdf

该篇文章基于对比学习和注意力机制引导提出了LoopCAG模型。LoopCAG可以根据输入的鼠标轨迹,生成与鼠标轨迹相匹配的图像描述,从而增强了图片描述生成的可控性和可解释性。

E2E-VLP: End-to-End Vision-Language Pretraining Enhanced by Visual Learning

论文地址:https://arxiv.org/pdf/2106.01804.pdf

这篇文章提出了一个端到端的视觉语言预训练模型。模型不需要利用预训练的目标检测器抽取基于区域的视觉特征,直接以图片作为输入。并且设计了两个额外的视觉预训练任务帮助模型学习细粒度的信息,达到了和两阶段模型相似的效果,并且提高了运算效率。

Enhancing Descriptive Image Captioning with Natural Language Inference

论文地址:https://aclanthology.org/2021.acl-short.36.pdf

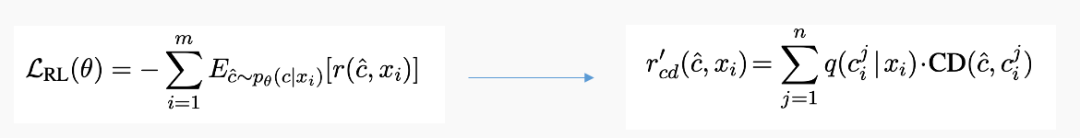

这篇文章通过推理图和PageRank对图像描述进行描述性打分。再通过参考抽样和加权指定奖励来生成具有更多细节的图像描述。模型生成了比一般方法具有更多细节的图像描述,这些图像描述可以包含基线方法生成的图像描述。

论文细节

1

动机

图像描述任务主要针对图片上比较突出的物体和物体关系展开描述,这样的图片描述没有考虑到用户意图。为了生成具备可控性和可解释性的图像描述,最近的工作提出了生成可控性的图像描述任务。为了生成符合用户意图的图像描述,通常会对描述加以情感、边界框和鼠标轨迹限制。与此同时,近期提出的 Localized-Narratives 数据集将鼠标轨迹作为图像描述任务的另一个输入,为图像描述生成任务中所涉及的语义概念进行空间和时序关系上的控制提供了可能。

模型

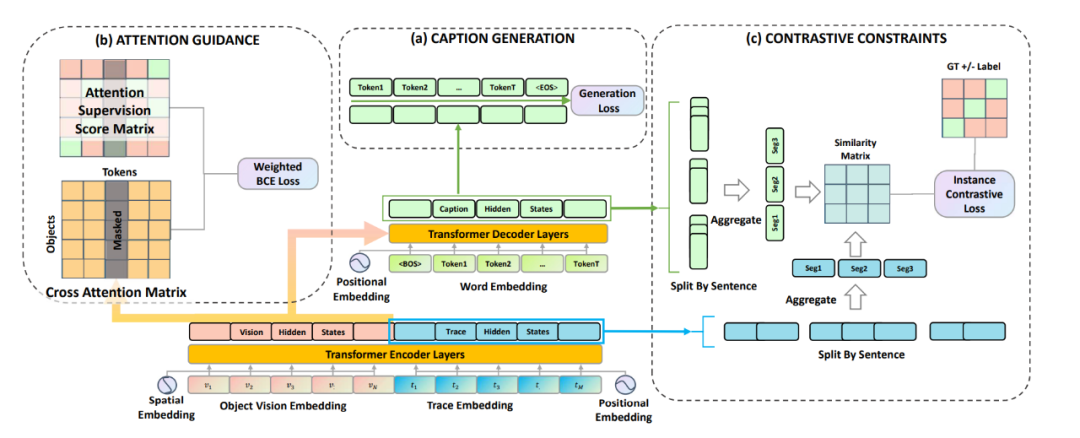

LoopCAG 可以总结为三部分:用于生成图片描述且以 Transformer 为主干网络的编码器-解码器;用于视觉对象空间定位的注意力引导(Attention Guidance)组件;用于句子级时序对齐的对比性约束(Contrastive Constraints)组件。

(1)Caption Generation

作者将视觉特征V和轨迹特征T分别编码,并叠加位置信息后得 和 ,然后串联在一起作为一个统一的序列输入编码器。解码器通过交叉注意力模块与编码器最后一层的隐藏状态相连,将视觉和轨迹信息结合起来作为生成的前置条件。解码器的优化目标是将以下目标函数最小化:

(2)Attention Guidance

为了定位物体,作者用轨迹作为中间桥梁联系物体和语义token。作者构建了一个监督矩阵来引导词语和视觉对象之间的注意力,即需要物体轨迹点尽可能多的落入对象边界框中。当注意力监督矩阵和模型的交叉注意力矩阵尽可能接近时,词语则可以准确的对应到图片的空间视觉物体上。

(3)Contrastive Constraints

作者使用对比损失函数来约束生成过程的时间顺序,对比损失的形式是 NCE 函数,用来学习区分轨迹-描述对之中的正例和负例。正例是指在顺序上自然对应的描述句和轨迹段,而其余的轨迹-描述对组合均为负例。

最后作者通过将所有损失的总和最小化来联合优化模型。

实验

作者在Localized-Narratives COCO 这个数据集上进行了训练和测试。在测试集上的结果如图所示,LoopCAG 方法在所有的自动评测指标上都达到了先进水平。从表中可以看出,ROUGE-L 的得分提升了2.0。由于 ROUGE-L 主要采用了对顺序敏感的最长共同子序列计分方式,这表明对比约束可以促进生成句子的顺序和用户意图的对应。

2

动机

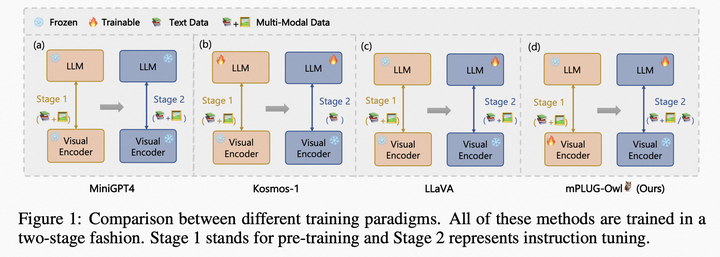

基于海量图文对的多模态预训练在下游的跨模态任务中已经取得巨大的成功。现有的多模态预训练的方法主要基于两阶段训练,首先利用预训练的目标检测器抽取基于区域的视觉特征,然后拼接视觉表示和文本向量作为Transformer的输入进行训练。这样的模型存在两点问题,一个是第一阶段通常在特定数据集进行训练模型泛化能力不好,此外提取区域的视觉特征比较耗费时间。基于此作者提出了端到端的像素级别的视觉语言预训练模型。模型通过一个统一的Transformer框架同时学习图像特征和多模态表示

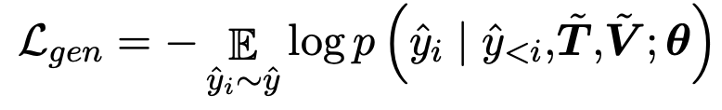

模型

本文的模型如图所示。E2E-VLP用一个CNN 模型提取图片视觉特征的同时用一个Transformer进行多模态特征学习。

(1) Input Representations

模型首先用WordPiece tokenizer 分词进行序列化。图片则直接以三通道的像素矩阵输入。

(2) Cross-modal Encoder Pre-training:Transformer

模型用Resnet提取图片的特征向量。用Transformer模块接受图像-句子的序列输入,进行跨模态语义学习。

为了提取跨模态语义信息,模型设计了两个预训练任务。一个是与Bert类似的Masked Language Modeling,只是在该任务中除去上下文信息还可以利用图片信息避免语义混淆,第二个任务是进行图片文本匹配。

(3) Visual-enhanced Decoder

为了提取更细粒度的视觉特征,接入了物体检测和描述生成两个任务。在物体检测中,为了增强视觉语义特征的学习,除去常规的位置和物体种类预测,我们引入了属性预测这一任务。描述生成图片对应的描述。

实验

根据实验结果,E2E-VLP 和两阶段模型相比,也取得了比较好效果,可以理解和完成两种任务。同时在参数量上,E2E-VLP 则具有更加轻量的优势。

3

动机

现阶段的图像描述模型通常倾向于生成比较安全的较为笼统的描述,而忽略图像细节。为了生成包含更多细节的图像描述,作者基于更具有细节的图像描述通常包含笼统描述的全部信息这一观点提出了基于自然语言推断的描述关系模型。

方法

这篇文章的具体方法如下:

(1)Constructing Inference Graphs

首先用基于Bert的自然语言推断模型判断图像描述之间的关系,由于图像描述之间不存在冲突因此挪去了冲突关系。并对一张图的描述构建如图所示的推断关系图,并利用Pagerank的方法对推断图计算描述性评分。

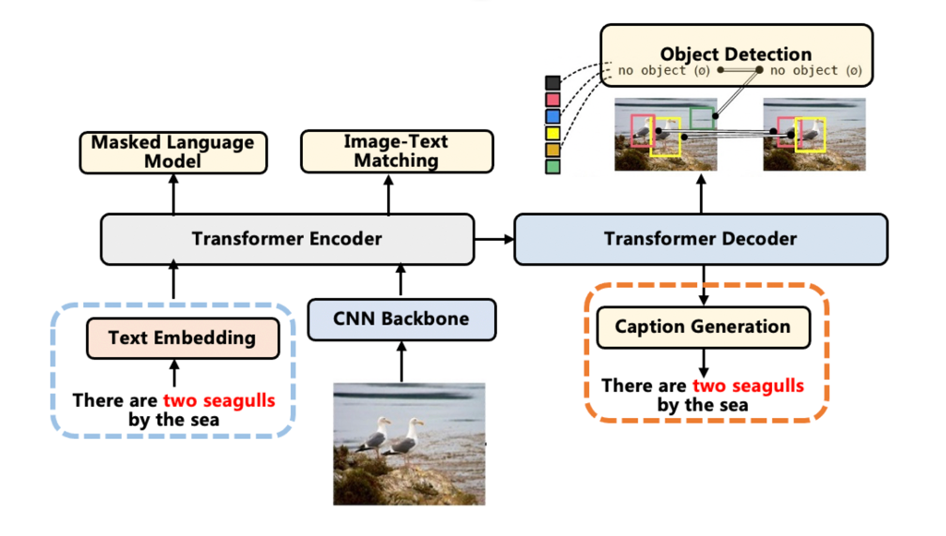

(2)Descriptiveness Regularized Learning

由于传统图像描述的第一阶段生成描述和图像描述最小化交叉熵损失函数等同于生成描述和均匀分布的图像描述之间的KL Divergence,为了生成更具有描述性的图像描述。则采用归一化的描述性评分分布取代均匀分布,认为更具有描述性的图像描述具有更高的生成概率。

在第二阶段,最大化生成图像描述的期望收益时,也同时用描述性评分取代均匀分布来计算期望收益。

实验

根据实验结果,模型在多数指标特别是CIDER评分上超过了Baseline,这是因为CIDER倾向于具有更加特殊的细节描述。

此外根据自然语言推断模型判断文章模型生成的图像描述对baseline的图像描述形成更多的包含关系。

编辑:jq

-

解码器

+关注

关注

9文章

1073浏览量

40146 -

编码器

+关注

关注

41文章

3359浏览量

131470 -

图像

+关注

关注

2文章

1063浏览量

40035 -

函数

+关注

关注

3文章

3863浏览量

61303 -

cnn

+关注

关注

3文章

326浏览量

21296

原文标题:ACL2021 | 跨视觉语言模态任务与方法

文章出处:【微信号:zenRRan,微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。

发布评论请先 登录

相关推荐

机器人基于开源的多模态语言视觉大模型

自动驾驶和多模态大语言模型的发展历程

用语言对齐多模态信息,北大腾讯等提出LanguageBind,刷新多个榜单

探究编辑多模态大语言模型的可行性

基于视觉的多模态触觉感知系统

更强更通用:智源「悟道3.0」Emu多模态大模型开源,在多模态序列中「补全一切」

如何利用LLM做多模态任务?

邱锡鹏团队提出具有内生跨模态能力的SpeechGPT,为多模态LLM指明方向

邱锡鹏团队提出SpeechGPT:具有内生跨模态能力的大语言模型

多模态GPT:国内发布一款可以在线使用的多模态聊天机器人!

如何利用LLM做多模态任务?

ACL2021的跨视觉语言模态论文之跨视觉语言模态任务与方法

ACL2021的跨视觉语言模态论文之跨视觉语言模态任务与方法

评论