Nvidia表示,已通过今年早些时候推出的A100 GPU芯片,扩大了在MLPerf Benchmark上进行AI推理的领先优势。Nvidia在第二版MLPerf Inference中赢得了针对数据中心和边缘计算系统的六个应用程序测试中的每一个。这些测试是对最初的两个计算机视觉基准测试的扩展-AI测试现在包括推荐系统,自然语言理解,语音识别和医学成像。

行业观察家Moor Insights&Strategy的HPC和机器学习高级分析师Karl Freund评论说,与Nvidia的展示一样令人印象深刻,还应该注意,某些原本有望参加MLPerf竞赛的公司却没有参加。。

弗洛伊德说:“英伟达在竞争激烈的竞争者中表现出色。” 与(Nvidia)V100(GPU)相比,他们的A100效果惊人,证明了其增强的Tensor核心架构的价值。我赞扬MLPerf添加了新的基准,这些基准越来越代表快速增长的推理机会,例如推荐引擎。

Freund说:“话说回来,竞争要么是因为客户项目太忙,要么是他们的芯片还没有准备好。” “例如,SambaNova(人工智能系统平台)宣布与LLNL建立新的合作伙伴关系,而英特尔Habana(可编程深度学习加速器)仍在酝酿中。如果我仍在芯片创业公司,我将等待运行MLPerf(一个昂贵的项目),直到我已经获得了一些灯塔客户。

英伟达在其结果公告中表示,其A100的AI推理速度比CPU快237倍。

Nvidia加速计算部总经理兼副总裁Ian Buck表示:“每个行业都在寻求更好的方式来应用AI提供新服务和发展业务,这是我们的转折点。” “我们为在MLPerf上实现这些结果而进行的工作使公司的AI性能达到了新的水平,从而改善了我们的日常生活。”

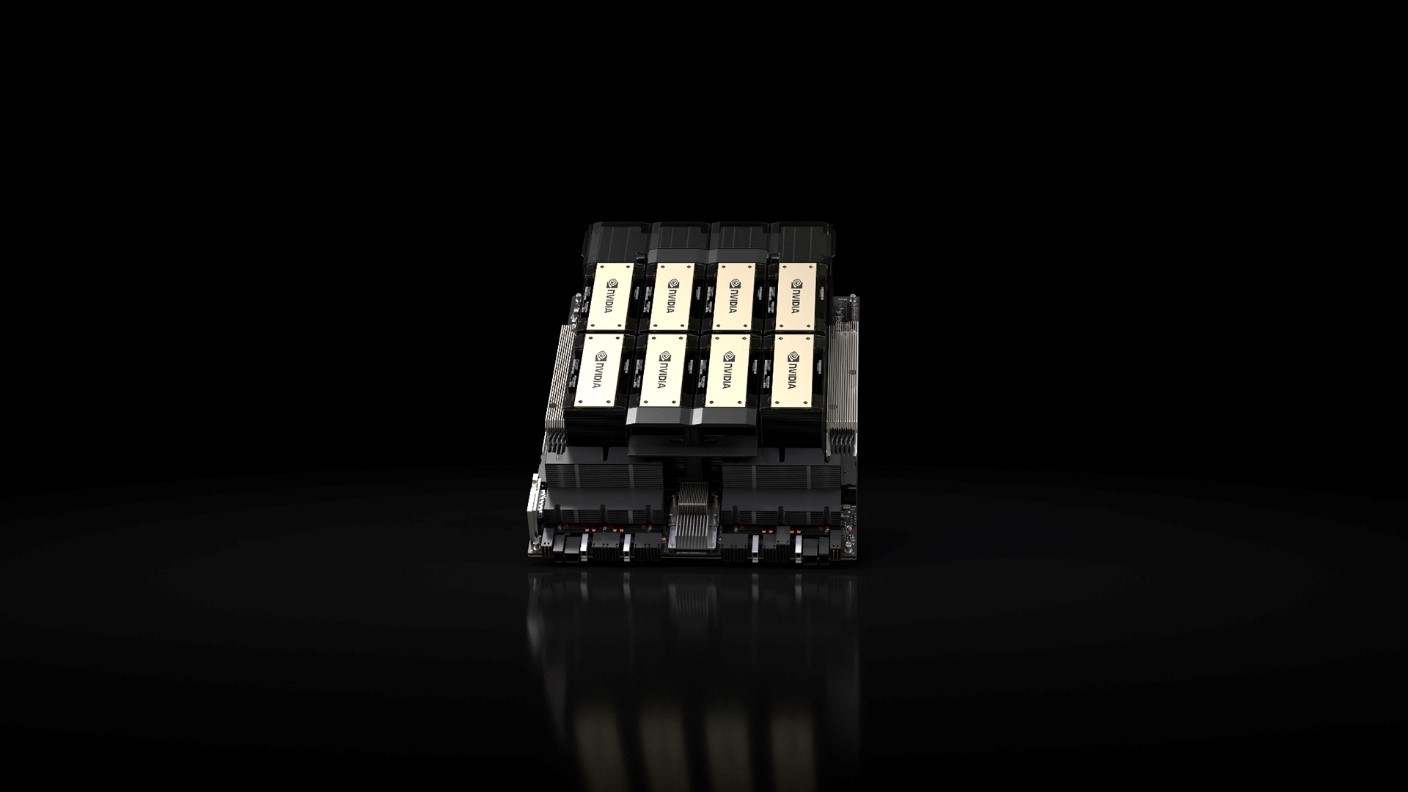

Nvidia表示,该公司及其合作伙伴使用Nvidia的加速平台(包括Nvidia数据中心GPU,Edge AI加速器和Nvidia优化的软件)提交了MLPerf 0.7结果。Nvidia A100于今年早些时候推出,具有第三代Tensor内核和多实例GPU技术,在ResNet-50测试中的领先优势得到了提高,比上一轮的CPU高出30倍,是6倍。该公司补充说,它的GPU在公共云中的AI推理能力首次超过了CPU,并表示Nvidia GPU上的云AI推理总能力每两年增长约10倍。

责任编辑:lq

-

NVIDIA

+关注

关注

14文章

4582浏览量

101682 -

机器学习

+关注

关注

66文章

8105浏览量

130542 -

GPU芯片

+关注

关注

1文章

285浏览量

5681 -

MLPerf

+关注

关注

0文章

33浏览量

599

发布评论请先 登录

相关推荐

利用NVIDIA组件提升GPU推理的吞吐

开发者手机 AI - 目标识别 demo

使用NVIDIA Triton推理服务器来加速AI预测

HarmonyOS:使用MindSpore Lite引擎进行模型推理

NVIDIA 为全球领先的 AI 计算平台 Hopper 再添新动力

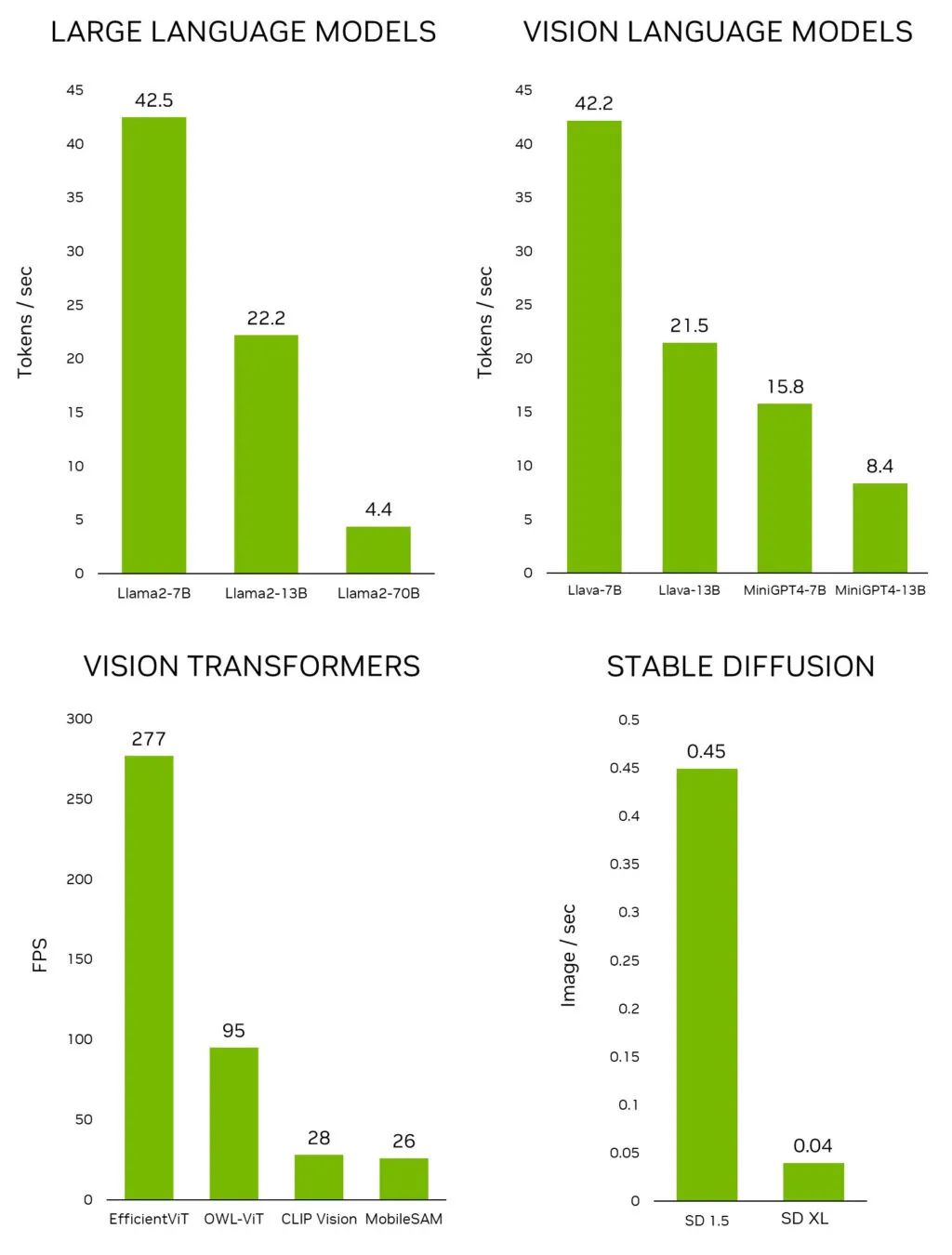

利用 NVIDIA Jetson 实现生成式 AI

周四研讨会预告 | 注册报名 NVIDIA AI Inference Day - 大模型推理线上研讨会

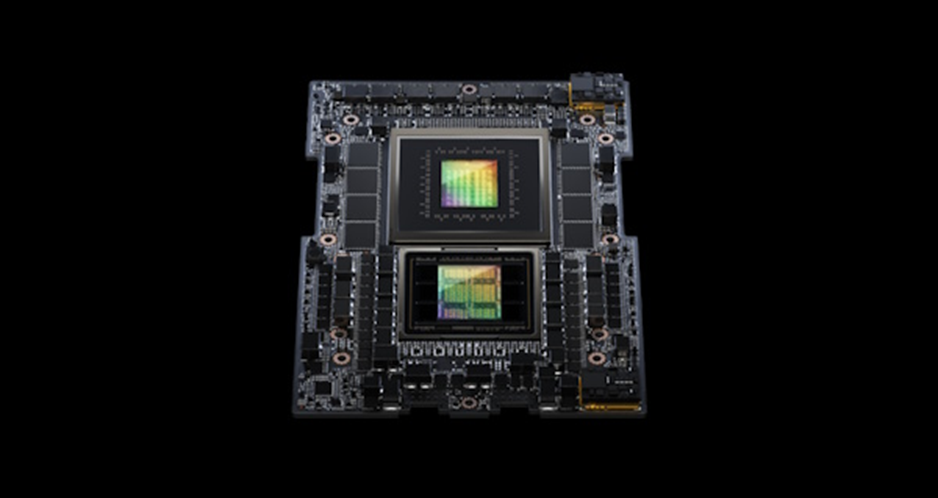

NVIDIA Grace Hopper超级芯片横扫MLPerf推理基准测试

NVIDIA Grace Hopper 超级芯片横扫 MLPerf 推理基准测试

最新MLPerf v3.1测试结果认证,Gaudi2在GPT-J模型上推理性能惊人

全球领先系统制造商推出 NVIDIA AI 就绪型服务器,为企业大幅提升生成式 AI 性能

新的 MLPerf 推理网络部分展现 NVIDIA InfiniBand 网络和 GPUDirect RDMA 的强大能力

Nvidia扩大了在MLPerf Benchmark上进行AI推理的领先优势

Nvidia扩大了在MLPerf Benchmark上进行AI推理的领先优势

评论