会话 AI 服务已经存在多年,但不论是聊天机器人,还是智能个人助理或搜索引擎,其理解能力很难达到与人类相当的水平。主要瓶颈则在于超大型AI模型的实施部署无法实现。正因如此,不论是Google、Microsoft、Facebook,还是阿里巴巴、百度等,都在模型的部署方面孜孜以求。

NVIDIA于太平洋时间8月13日宣布重大突破:BERT训练时间实现创纪录的53分钟,推理时间缩短至2毫秒,并构建了迄今为止同类型中最大的语言模型,使得实时会话 AI与用户进行互动时更为自然。

超大模型面前,GPU再证强大可扩展性

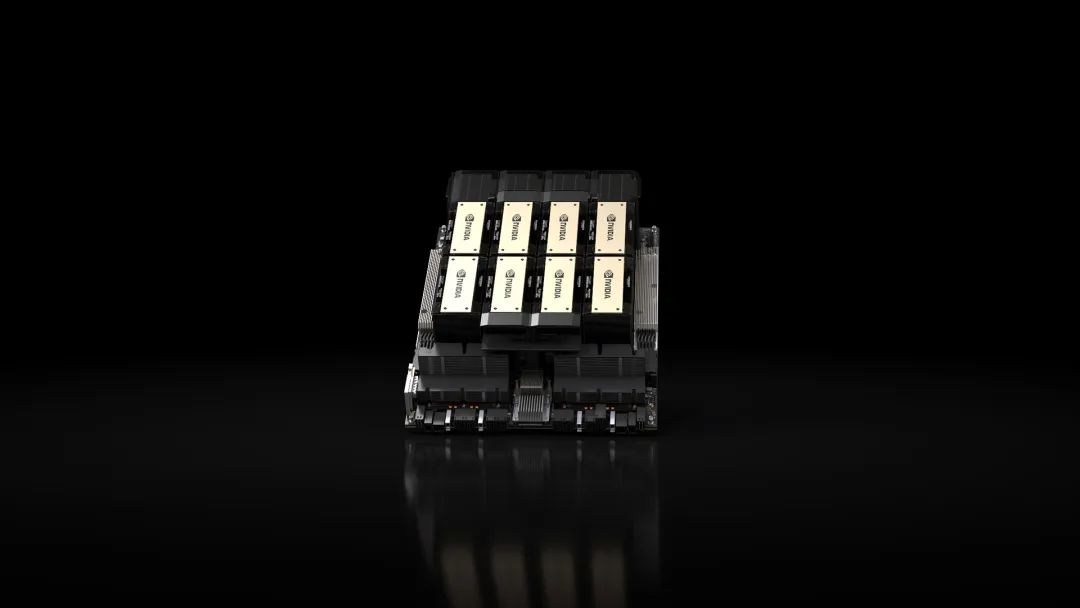

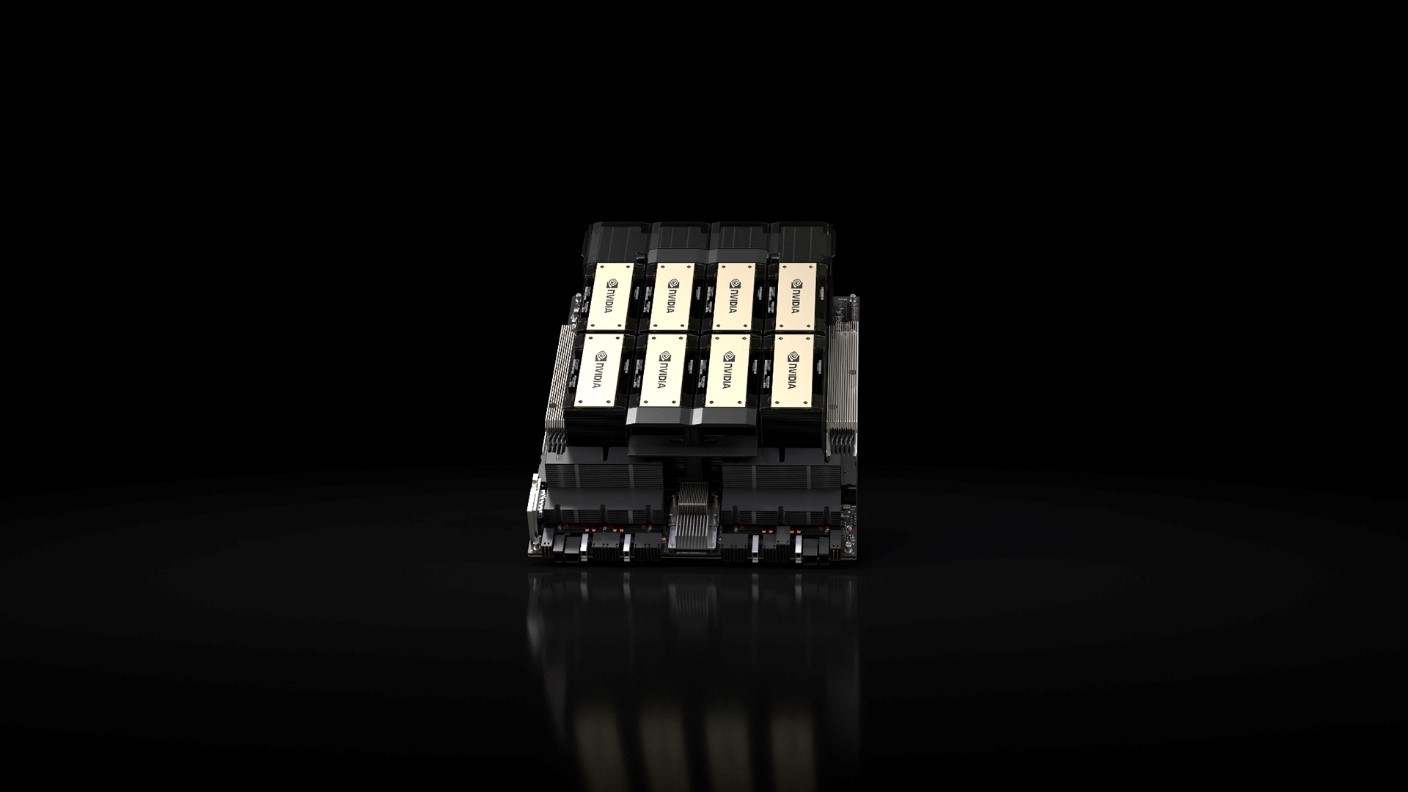

BERT(Bidirectional Encoder Representations from Transformers)是世界上最先进的AI语言模型之一,Google于去年发布不久就刷爆AI业界。作为一种新型的语言模型,它只需一个额外的输出层对预训练BERT进行微调就可以满足各种任务,而无需再对模型进行修改,实现了在11项NLP任务上取得突破进展。在对BERT模型进行训练时,NVIDIA使用搭载了92台 NVIDIA DGX-2H系统的 NVIDIA DGX SuperPOD运行该模型的大型版本,凭借1472个NVIDIA V100 GPU的强大性能,NVIDIA将BERT-Large的典型训练时间从几天缩短至仅仅 53 分钟。

此外,NVIDIA还在单独一台NVIDIA DGX-2系统上执行了BERT-Large 模型的训练任务,用时也仅为 2.8天,充分体现了GPU在会话 AI 方面的可扩展性。

推理方面,借助于运行了NVIDIA TensorRT的NVIDIA T4 GPU,NVIDIA 执行 BERT-Base SQuAD数据集的推理任务,用时仅为2.2毫秒,远低于许多实时应用程序所需的10毫秒处理阈值;与使用高度优化的CPU代码时所测得的40多毫秒相比,有着显著改进。

对此,NVIDIA 深度学习应用研究副总裁 Bryan Catanzaro 表示,“对于适用于自然语言的AI而言,大型语言模型正在为其带来革新。NVIDIA 所取得的突破性工作成果加速了这些模型的创建,它们能够帮助解决那些最为棘手的语言问题,让我们距离实现真正的会话 AI 更进了一步。

NVIDIA BERT推理解决方案Faster Transformer宣布开源

开发者们对于更大模型的需求正在日益增长,NVIDIA 研究团队基于Transformer构建并训练了世界上最大的语言模型。Transformer是BERT的技术构件,正被越来越多的其他自然语言AI模型所使用。NVIDIA定制的模型包含83亿个参数,是BERT-Large的24 倍。2017年12月Google在论文“Attention is All You Need”中首次提出了Transformer,将其作为一种通用高效的特征抽取器。至今,Transformer已经被多种NLP模型采用,比如BERT以及上月发布重刷其记录的XLNet,这些模型在多项NLP任务中都有突出表现。在NLP之外,TTS、ASR等领域也在逐步采用Transformer。可以预见,Transformer这个简洁有效的网络结构会像CNN和RNN一样被广泛采用。

不过,虽然Transformer在多种场景下都有优秀表现,但是在推理部署阶段,其计算性能却受到了巨大的挑战:以BERT为原型的多层Transformer模型,其性能常常难以满足在线业务对于低延迟(保证服务质量)和高吞吐(考虑成本)的要求。以BERT-BASE为例,超过90%的计算时间消耗在12层Transformer的前向计算上。因此,一个高效的Transformer 前向计算方案,既可以为在线业务带来降本增效的作用,也有利于以Transformer结构为核心的各类网络在更多实际工业场景中落地。

NVIDIA GPU计算专家团队针对Transformer推理提出的性能优化方案Faster Transformer宣布开源,其底层基于CUDA和cuBLAS,是一个BERT Transformer 单层前向计算的高效实现,其代码简洁明了,后续可以通过简单修改支持多种Transformer结构。目前优化集中在编码器(encoder)的前向计算(解码器decoder开发在后续特性规划中),能够助力于多种BERT的应用场景。Faster Transformer对外提供C++ API,TensorFlow OP 接口,以及TensorRT插件,并提供了相应的示例,用以支持用户将其集成到不同的线上应用代码中。

2021年15%的客服互动将通过AI完成

预计未来几年,基于自然语言理解的 AI 服务将呈指数级增长。根据Juniper Research 的研究表明,在未来4年中,仅数字语音助手的数量就将有望从25 亿攀升到 80 亿。此外,据Gartner预计,到 2021 年,15%的客服互动都将通过AI完成,相比2017年将增长4倍。当前,全球数以百计的开发者都使用 NVIDIA 的 AI 平台,来推进他们自己的语言理解研究并创建新的服务。

Microsoft Bing正在通过先进的 AI 模型和计算平台,为客户提供更好的搜索体验。通过与 NVIDIA 密切合作,Bing 使用 NVIDIA GPU(Azure AI 基础设施的一部分)进一步优化了热门自然语言模型 BERT 的推理功能,从而大幅提升了 Bing 于去年部署的排名搜索的搜索质量。与基于 CPU 的平台相比,使用 Azure NVIDIA GPU 进行推理,延迟降低了一半,吞吐量提升了5倍。

多家初创公司(例如Clinc、Passage AI 和Recordsure等)正在使用 NVIDIA的AI平台为银行、汽车制造商、零售商、医疗服务提供商、旅行社和酒店等客户构建先进的会话 AI 服务。据悉,中国市场也有相应的合作伙伴,日后将进一步公开。

会话AI才是真正意义上的人工智能的基本特征,不论是语言模型还是训练、推理,底层技术的逐步强大,才是实现这一切的基础。距离我们所期望的人工智能虽然还很遥远,但技术上的每一次突破都值得记载。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

NVIDIA

+关注

关注

14文章

4588浏览量

101702 -

gpu

+关注

关注

27文章

4415浏览量

126663

发布评论请先 登录

相关推荐

利用NVIDIA组件提升GPU推理的吞吐

本实践中,唯品会 AI 平台与 NVIDIA 团队合作,结合 NVIDIA TensorRT 和 NVIDIA Merlin HierarchicalKV(HKV)将推理的稠密网络和热

全新NVIDIA RTX A400和A1000 GPU全面加强AI设计与生产力工作流

两款 NVIDIA Ampere 架构 GPU 为工作站带来实时光线追踪功能和生成式 AI 工具支持。

有什么方法可以进一步提高AD7714的分辨率啊?

级放大再加给AD7714时,测得人分辨率还要低一些。由于是用干电池得到AD7714的输入信号,该信号相对来说很稳定,而且板上的噪声也不是太大。请问各位大虾,还有什么方法可以进一步提高AD7714的分辨率啊?不胜感激!

发表于 12-25 06:33

借助人工智能,存储器比重将进一步增加

SK海力士预测在人工智能(AI)领域,存储器解决方案的比重将进一步增加,可以通过类似AiMX的解决方案部分替代图形处理单元(GPU)。

发表于 12-04 09:52

•186次阅读

ad9106如何将波形频率设置为进一步降低到10Hz?

你好,我有一个小问题。我使用100m时钟芯片。每个时钟只有10ns,ad9106寄存器的最小输出波形只有100Hz。如何将波形频率设置为进一步降低到10Hz?我已将配置设置为相关寄存器的最大值。拍

发表于 12-01 06:12

SC23 | NVIDIA 为全球领先的 AI 计算平台 Hopper 再添新动力

再添新动力。 NVIDIA H200 是首款采用 HBM3e 的 GPU,其运行更快、更大的显存容量将进一步加速生成式 AI 与大语言模型,同时推进用于 HPC 工作负载的科学计算。凭

NVIDIA 为全球领先的 AI 计算平台 Hopper 再添新动力

Tensor Core GPU 和领先的显存配置,可处理生成式 AI 与高性能计算工作负载的海量数据。 NVIDIA H200 是首款采用 HBM3e 的 GPU,其运行更快、更

发表于 11-14 14:30

•103次阅读

NVIDIA Grace Hopper超级芯片横扫MLPerf推理基准测试

Hopper超级芯片首次亮相 MLPerf 行业基准测试,其运行了所有数据中心推理测试,进一步扩大了NVIDIA H100 Tensor Core GPU的领先优势。 总体测试结果表明,

发表于 09-13 09:45

•165次阅读

谷歌云与 NVIDIA 进一步深化合作

这一需求,谷歌云近日宣布全面推出由 NVIDIA H100 Tensor Core GPU 驱动的全新 A3 实例。NVIDIA H100 Tensor Core GPU 通过专为加速

VMware 与 NVIDIA 为企业开启生成式 AI 时代

全新 VMware Private AI Foundation With NVIDIA 帮助企业为生成式 AI 在业务中的应用做好准备;该平台将在数据隐私性、安全性和可控性方面提供进一步

GPU可用的不同级别的数值精度介绍

他们的着色器性能进一步。

当您完成本指南时,您将理解16浮点值和32浮点值浮点值,着色精度,舍入值,低精度的利弊,纹理坐标,以及如何减轻精度的损失。

发表于 08-02 10:52

美国或在半导体、人工智能和量子计算考虑进一步对我国加以限制

美国或在半导体、人工智能和量子计算考虑进一步对我国加以限制 目前人工智能发展迅猛,与之相关的AI大模型训练在加速跟上,市场需求很大,对应的AI芯片主要是英伟达的A100、H100以及

发表于 06-29 10:54

•358次阅读

NVIDIA GPU再创壮举,距真正会话AI又进一步!

NVIDIA GPU再创壮举,距真正会话AI又进一步!

评论